Le JPEG2000 a été sélectionné parmi un panel de plusieurs autres méthodes de compressions et décompressions.

Le JPEG2000 a un avantage avec sa compression basée sur les ondelettes - la transformation en Ondelettes Discrète (Discrete Wavelet Transform ou DWT) - ce qui permet lors d'une compression plus ou moins accentuée, une image nette (compression basse) ou un peu plus floue (compression forte) au lieu d'artefacts de compression classique qui se manifestent par des blocs de pixelisation 1.

L'autre avantage est que dans un 4K, vous aurez aussi une version 2K 2 . Cela veut donc dire que pour générer du 4K, vous générer en même temps le 2K en une seule passe d'encodage !

Le JPEG2000 supporte à la fois la compression avec perte, destructive (utilisée pour le DCP) et sans perte, donc non destructive (utilisée pour l'IMF / DCDM).

Le JPEG2000 permet d'avoir des qualités différentes dans différentes zones de l'image. Très utile au cinéma où la zone d'intérêt est surtout au centre de l'image 3 . Vous pourriez avoir une compression forte sur l'ensemble de l'image sauf sur les visages des acteurs ou actrices par exemple.

La base du JPEG2000 (Core Coding System) est orientée royalty-free.

Pour comprendre la méthode de compression multi-résolutions du JPEG2000, il faut faire une petite incursion dans le monde magique des ondelettes (wavelets)

Déjà, il faut savoir qu'il existe plusieurs types d'ondelettes (Haar, Db, Fwt, ...). Appelées familles, vous pourrez avoir plusieurs ondelettes dans un type spécifique.

Le JPEG2000 utilise une famille particulière, celle des transformées en ondelettes discrètes (Discret Wavelet Transform ou surnommé DWT) intégrant notamment la décomposition multirésolution.

Historiquement, la première "ondelette" a été créée par Alfred Haar fr en 1909.

En comprenant son principe, on comprend les autres types d'ondelettes qui sont venues par la suite et utilisent des mécanismes et des équations encore plus complexes dont notamment celles utilisées par le JPEG2000.

Les deux types ondelettes utilisés dans le JPEG2000 sont celles de Ingrid Daubechies fr et celles de Didier Le Gall & Ali J. Tamatabai, et surnommées :

Celle que nous utiliserons dans le DCP est donc l'ondelette Daubechies 9/7.

Avant d'attaquer les ondelettes Daubechies, qui sont relativement complexes au premier abord, nous allons d'abord étudier les bases des ondelettes.

Pour comprendre le principe des ondelettes, nous allons utiliser et étudier une version simplifiée.

Normalement, les ondelettes intègrent 4 composantes essentielles :

Une fonction de scaling qui va utiliser des coefficients d'approximations.

Une fonction wavelet qui va utiliser des coefficients de détails.

Un filtre passe-bas qui va créer des coefficients d'approximations.

Un filtre passe-haut qui vont créer des coefficients de détails.

Pour nos besoins en simplification, nous allons tout d'abord écarter ces concepts et clarifier tout ceci avec un gros travail de vulgarisation. Les plus matheux voudront bien m'excuser, l'objectif étant de comprendre la "big picture" du principe des ondelettes, le sujet étant très vaste et très mathématique, il est préférable de simplifier à outrance.

Dans la suite du paragraphe, je vais éviter au possible de balancer des équations, juste pour balancer de l'équation qui ne nous serviront aucunement à comprendre sans avoir un certain niveau de mathématique. Le but ultime étant de comprendre comment fonctionne le JPEG2000 dans notre cas.

Avant de partir sur notre route des calculs, partons d'une simple image en noir et blanc (plus simple car on ne s'occupera que d'une composante de couleur) :

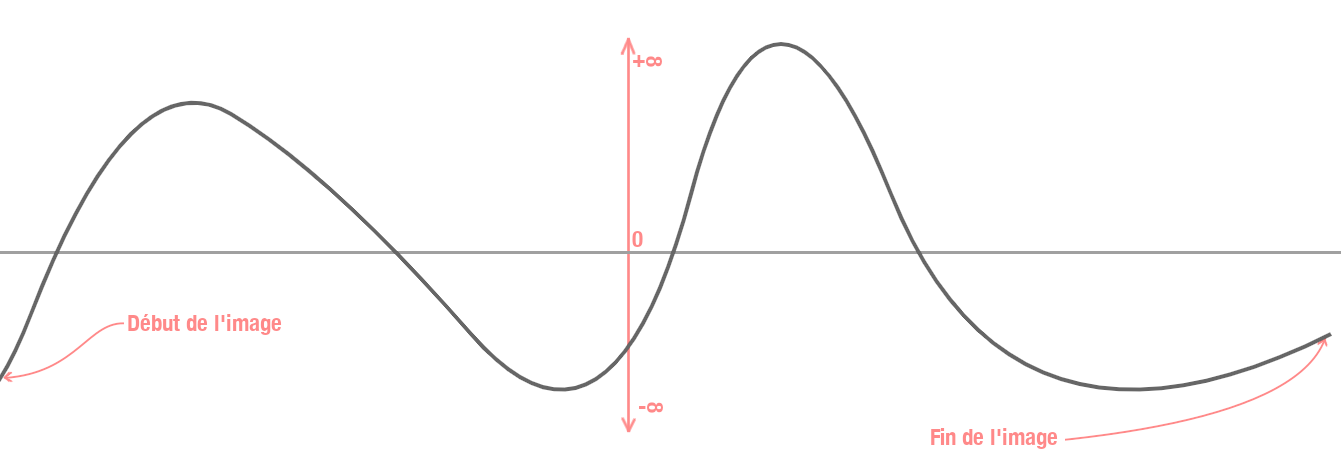

Prenons chaque valeur de chaque pixel sur différents niveaux noir, blanc et gris pour les poser sur un graphe idéal: le premier pixel de notre image sera au tout début de notre graphe et le dernier pixel en toute fin :

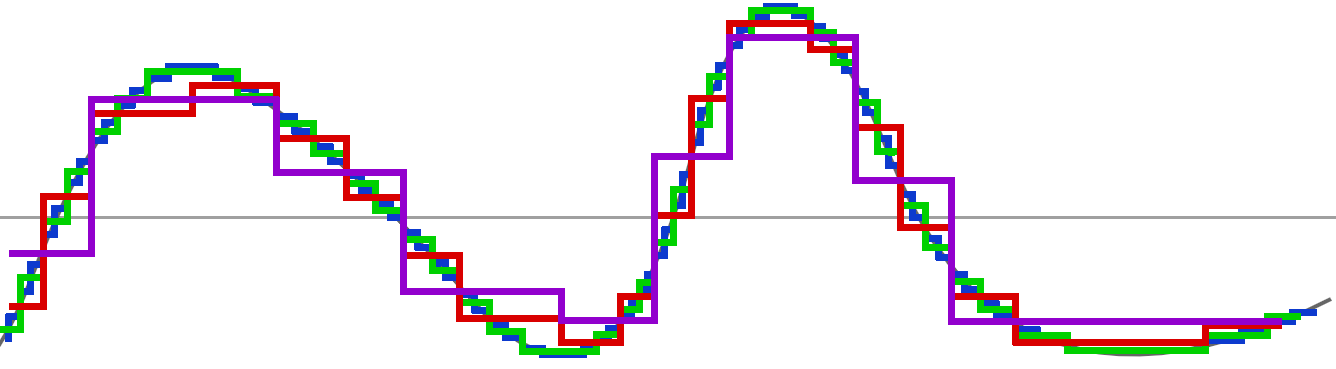

Pour interpréter cette courbe, imaginez juste que les points les plus bas sont les plus sombres et les points les plus hauts, les plus lumineux. Cette courbe est idéale et surtout imaginaire. En vérité, notre graphe ressemblerait plutôt à cela, où chaque point d'escalier représente véritablement les valeurs de nos pixels :

Chaque point représente la valeur d'un pixel selon un certain bitdepth (8, 16, 24, etc..). Les escaliers sont un peu énormes pour notre exemple (nous pourrions avoir une plus grande finesse dans les valeurs avec un bitdepth plus haut).

Nous ne sommes pas encore dans la partie ondelette, nous posons juste la base de ce qu'est une image numérique : une série de valeurs avec un minimum (0) et un maximum (255 par exemple).

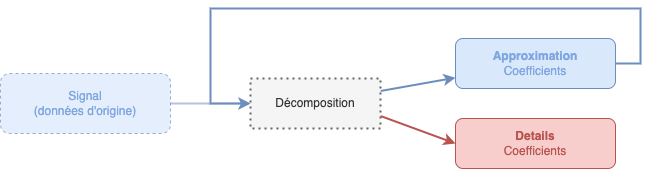

Le principe primaire des ondelettes est d'avoir deux fonctions : une fonction de scaling et une fonction wavelet qui vont toutes les deux travailler ensemble pour décomposer ou recomposer l'image.

Pour comprendre l'utilité, nous allons procéder à la première étape, celle de calculer la "moyenne entre deux points".

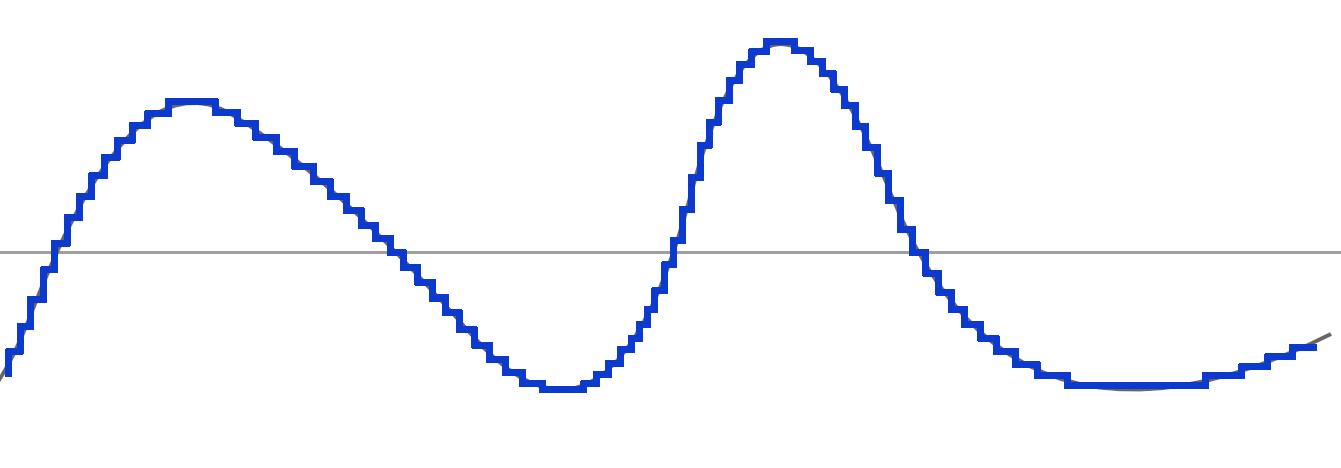

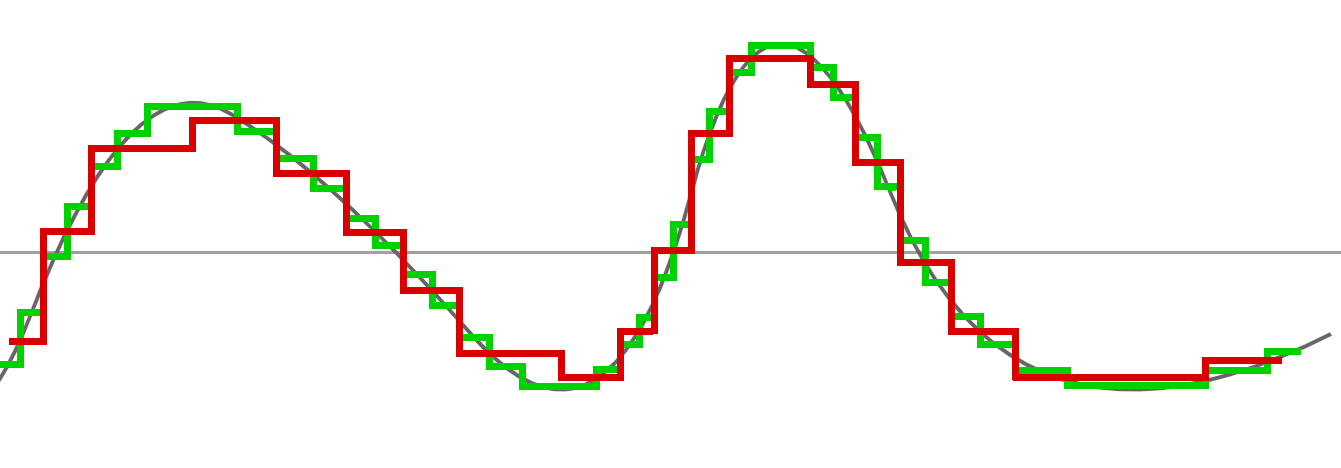

Si vous regardez bien le graphe suivant, vous verrez que notre courbe verte va traverser notre courbe bleue à certains endroits en son milieu, c'est parce que nous avons effectué une moyenne entre les deux points :

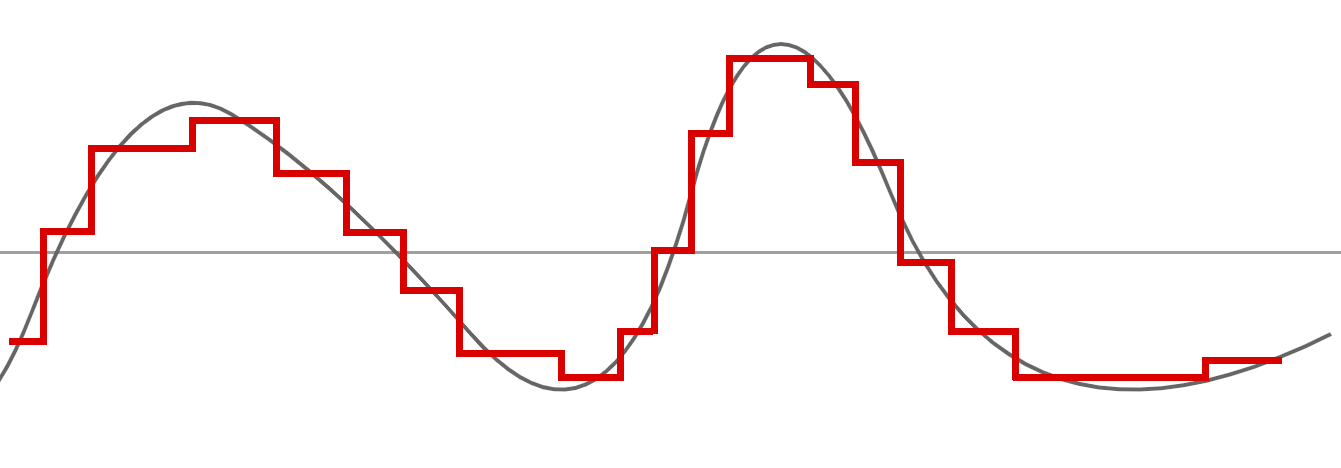

Si nous enlevons notre approximation précédente et nous gardons notre nouvelle "moyenne", voila le résultat :

Nous restons assez proches de la première courbe, cependant, vous remarquez que nous avons moins de points, donc moins de données.

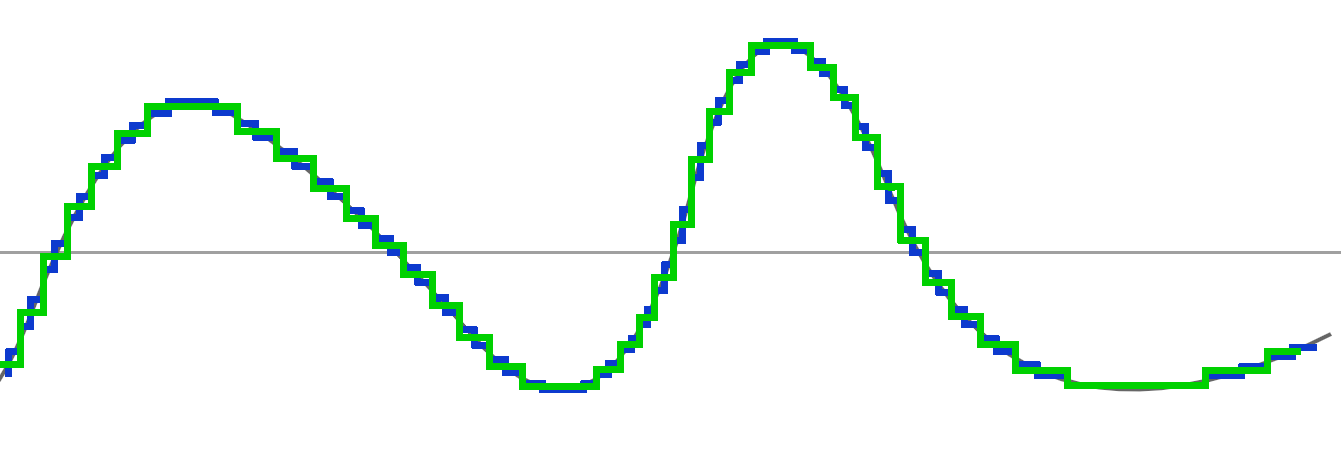

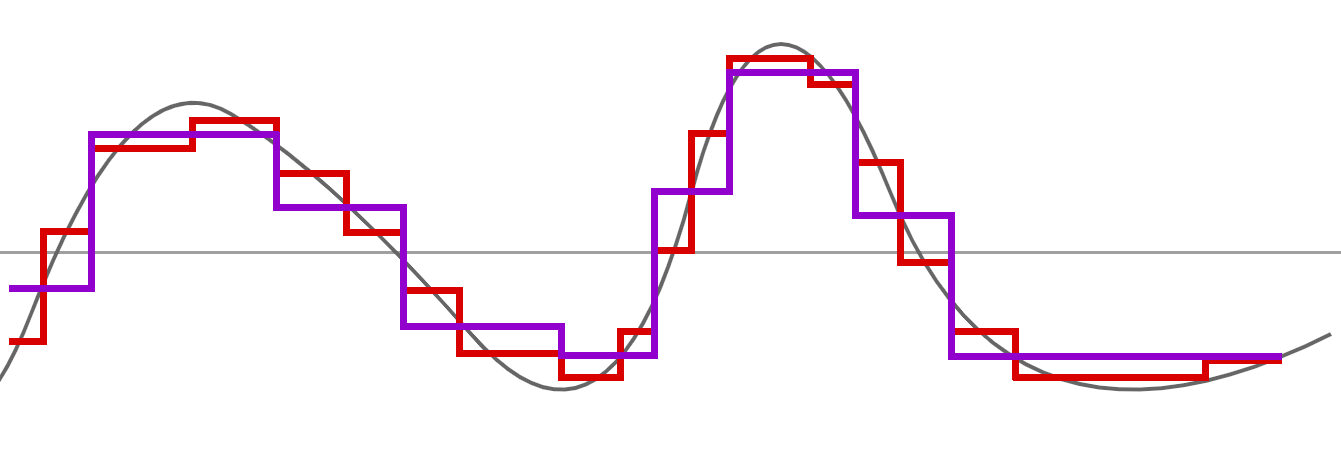

Avec cette nouvelle approximation, nous effectuons une nouvelle passe "moyenne" :

Notre nouvelle ligne rouge reste encore assez proche de notre première courbe :

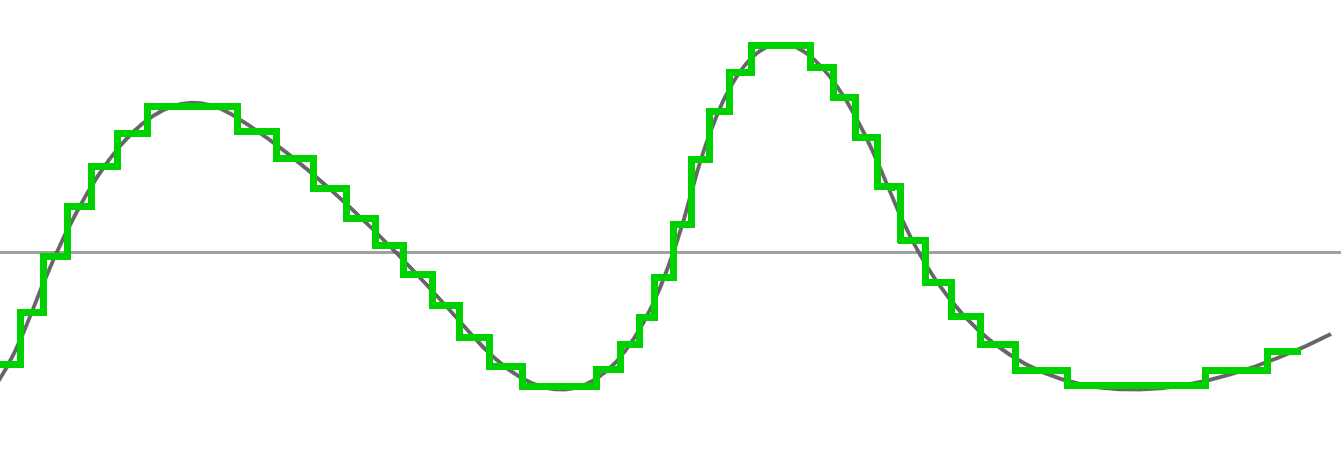

Et nous effectuons -encore- une nouvelle passe de moyenne sur l'approximation rouge :

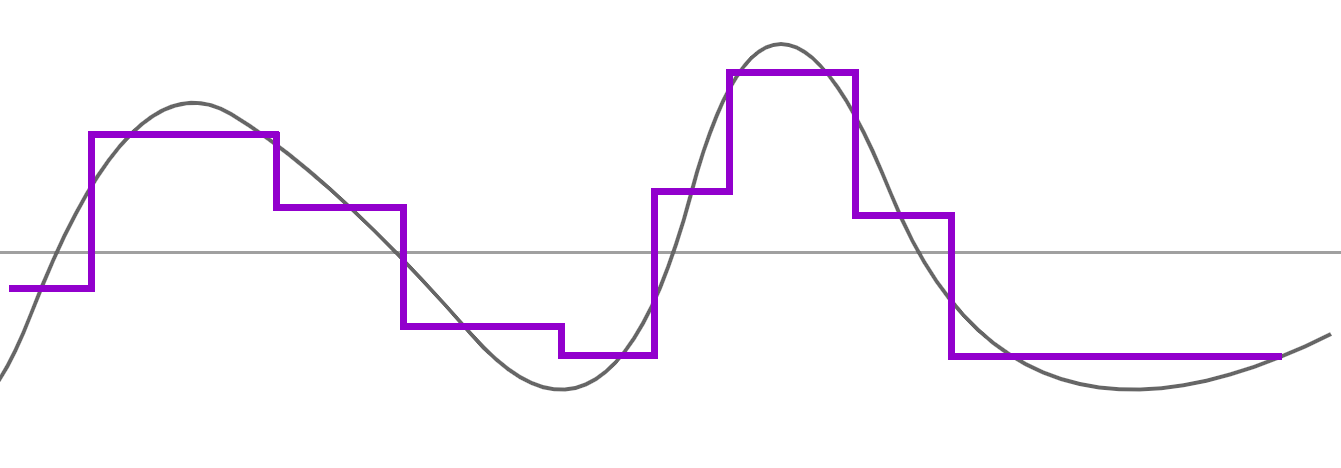

Ce qui nous donne une très grosse approximation :

Nous pourrions continuer mais cela n'aurait aucun intérêt car nous allons arriver à un niveau où nous n'aurons plus assez de données pour représenter quelque chose (à la fin, nous n'aurions plus qu'une ligne droite...)

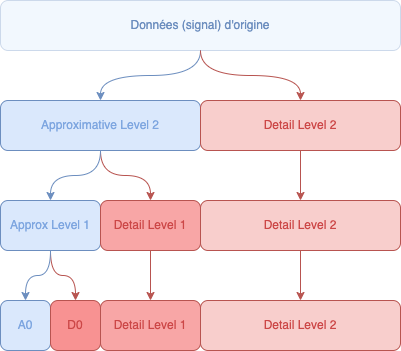

Chaque "passe" de moyenne représente une résolution différente. Ainsi la toute première peut représenter notre image en 2K et la toute dernière, notre image en 128x68.

Si on combine les différentes passes, nous voyons l'évolution des différentes décompositions à travers ces moyennes appliquées :

Notre version complète avec nos différents graphes combinés est (un peu) notre JPEG2000 avec ses différentes résolutions intégrées: notre JPEG2000 possèdera notre image 4K, mais aussi 2K et d'autres résolutions inférieures intermédiaires :

Vous me direz qu'un changement de bitdepth (passer de 16 bits à 8 bits par exemple) donneraient une résolution inférieure également, avec quasiment le même genre de résultat ? Sauf qu'avec la méthode des ondelettes, vous aurez l'ensemble des résolutions intermédiaires disponibles à tout moment et dans un seul et même flux ! (et même pouvoir avoir une résolution plus haute sur une toute petite zone en gardant le reste en basse résolution !)

Le principe des ondelettes est - entre autres - une série de calculs où nous arrivons avec des valeurs approximatives tout en conservant des valeurs intermédiaires qui nous permettent de revenir à l'original tout en conservant les résolutions intermédiaires.

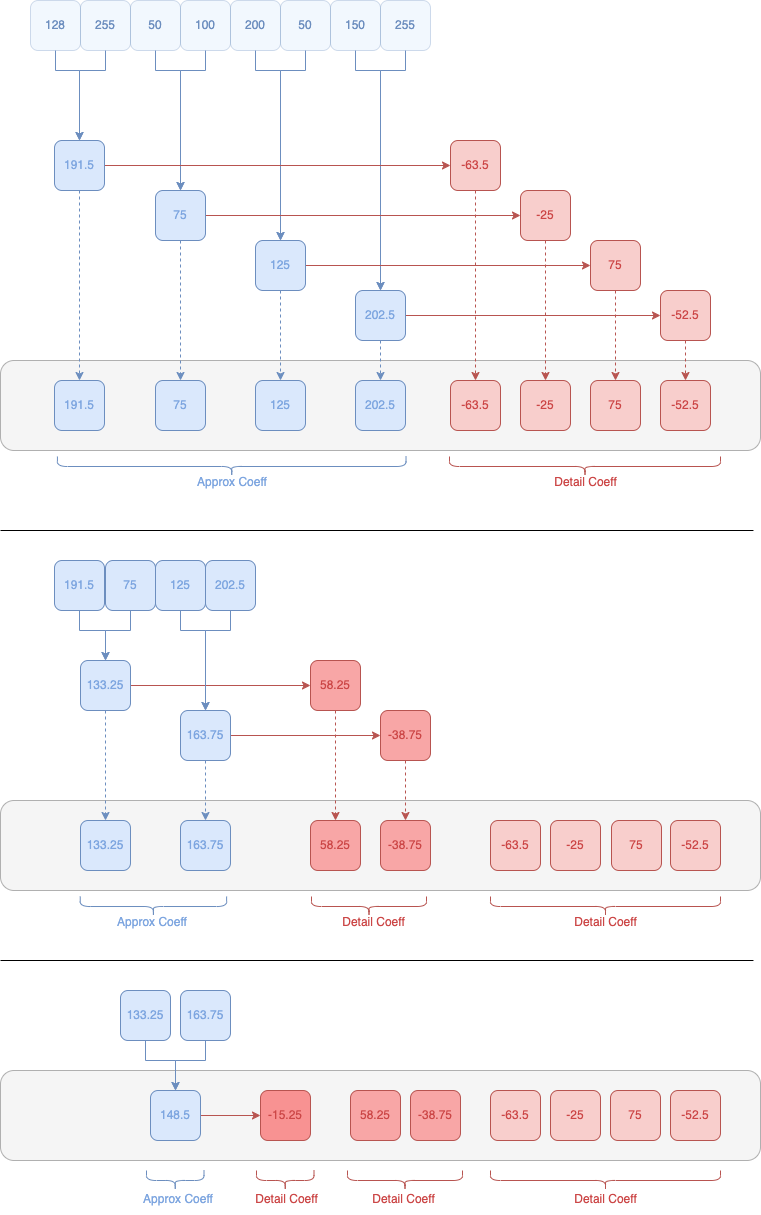

Les valeurs moyennes sont appelées Coefficients d'approximations (approximation coefficients) et les valeurs de différences - donc les valeurs conservant des informations importantes pour la décomposition ou la recomposition - sont appelées Coefficients de détails (detail coefficients).

Dans nos exemples graphiques, nous voyons bien nos approximations mais il n'existe aucune valeur intermédiaire, il faut donc trouver une méthode pour conserver ces fameuses valeurs, nous allons donc voir plus en profondeur comment les calculer.

Ce que nous allons faire maintenant, c'est calculer ces différents coefficients d'approximations et coefficients de détails.

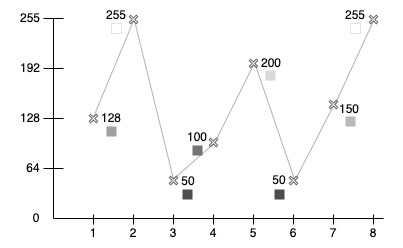

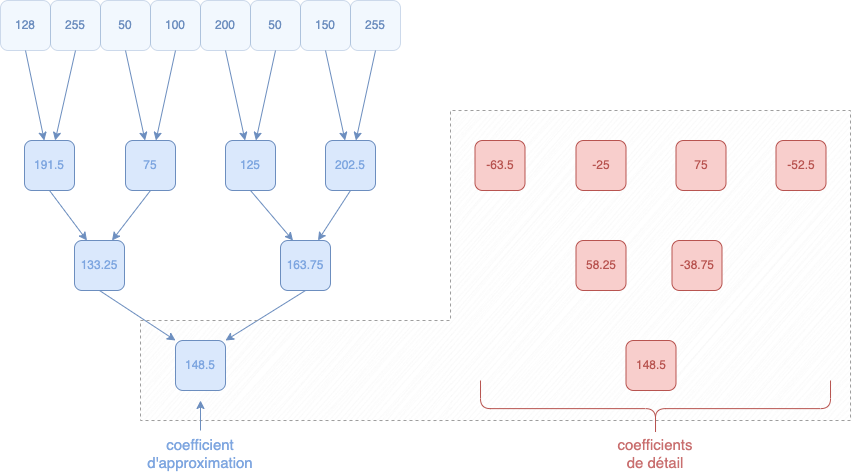

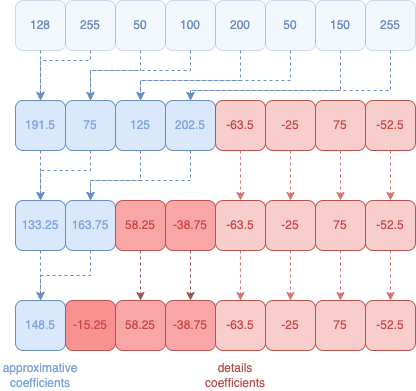

Pour commencer, prenons une suite de valeurs pour nos données : 128, 255, 50, 100, 200, 50, 150, 255.

Dans la majorité des documentations, cette suite de données est appelée le signal. Ne vous inquiétez pas par cette terminologie. Gardez simplement que « signal = suite de données » et que - en général - on évoque le terme de signal pour les données de départ.

Ces valeurs représentent les 8 premiers pixels de notre image en noir et blanc (et en 8 bits, donc de 0 à 255). Ainsi, 0 correspond à un noir parfait, 128 à un gris et 255 un blanc absolu.

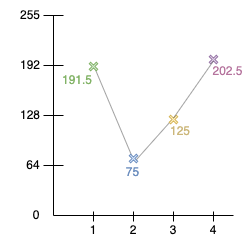

Posons nos différentes valeurs sur un graphe :

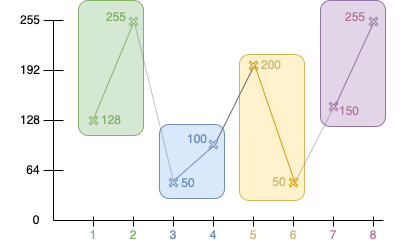

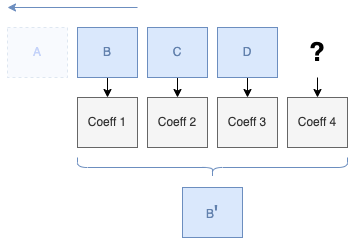

Pour débuter notre calcul en ondelettes, nous avons besoin de regrouper nos différentes valeurs par des blocs de deux unités :

Pour calculer nos coefficients, nous devons calculer la moitié des deux valeurs pour obtenir l'approximation, et calculer afin d'obtenir la différence entre l'approximation et le chiffre secondaire du couple 4 :

Approximation : ( A + B ) / 2

Detail : ( Approx - B ) ou ( A - B ) / 2

Si nous prenons nos deux premières valeurs :

Approximation n°1 : ( 128 + 255 ) / 2 = 191.5

Notre premier coefficient d'approximation est donc 191.5.

Nous effectuons cela pour l'ensemble des couples de valeurs :

Approximation n°1 : ( 128 + 255 ) / 2 = 191.5

Approximation n°2 : ( 50 + 100 ) / 2 = 75

Approximation n°3 : ( 200 + 50 ) / 2 = 125

Approximation n°4 : ( 150 + 255 ) / 2 = 202.5

Nos premiers coefficients d'approximations sont donc ( 191.5, 75, 125, 202.5 )

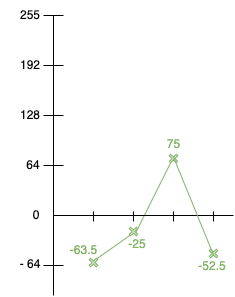

Bien entendu, nous devons aussi conserver les valeurs intermédiaires, appelés coefficient de détails.

Pour calculer le coefficient de détails, nous allons utiliser la moyenne (ou approximation) et la seconde valeur dans notre couple de valeurs [6] :

Detail n°1 : ( 191.5 - 255 ) = -63.5 ou ( 128 - 255 ) / 2 = -63.5

Detail n°2 : ( 75 - 100 ) = -25 ou ( 50 - 100 ) / 2 = -25

Detail n°3 : ( 125 - 50 ) = 75 ou ( 200 - 50 ) / 2 = 75

Detail n°4 : ( 202.5 - 255 ) = -52.5 ou ( 150 - 255 ) / 2 = -52.5

Nos premiers coefficients de détails sont donc ( -63.5, -25, 75, -52.5 )

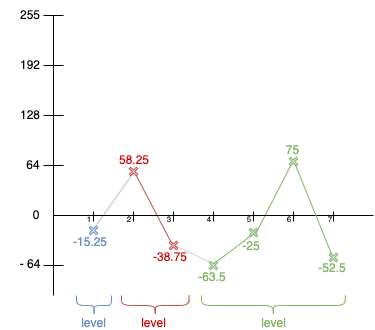

Maintenant, nous allons placer nos différentes nouvelles valeurs sur un graphe :

|

|

| Coefficients Approximations | Coefficients Détails |

|---|

Ceci est notre premier niveau de décomposition !

Nos valeurs sont donc maintenant :

| Approximations | Details |

|---|---|

191.5, 75, 125, 202.5 |

-63.5, -25, 75, -52.5 |

Notre but maintenant, c'est d'arriver à la plus petite base d'approximation possible.

Ici, nous constatons que nous avons encore 4 valeurs dans nos coefficients d'approximations (191.5, ...).

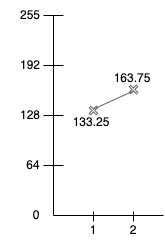

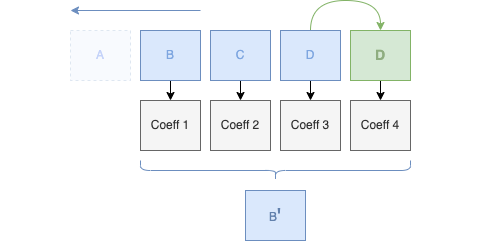

Nous allons passer à la seconde décomposition en ne prenant que les 4 coefficients d'approximations restants (191.5, 75, 125, 202.5), et nous allons de nouveau les regrouper par deux pour les besoins de nos calculs afin d'avoir de nouveaux coefficients approximations :

Approximation n°1 : (191.5 + 75) / 2 = 133.25

Approximation n°2 : (125 + 202.5 ) / 2 = 163.75

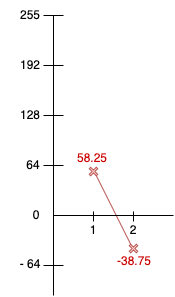

Et nous récupérons également nos coefficients de détails :

Detail n°1 : ( 133.25 - 75 ) = 58.25 ou ( 191.5 - 75 ) / 2 = 58.25

Detail n°2 : ( 163.75 - 202.5 ) = -38.75 ou ( 125 - 202.5 ) / 2 = -38.75

Et plaçons-les de nouveau dans un graphe :

|

|

| Coefficients Approximations | Coefficients Détails |

|---|

Nos nouvelles valeurs de décomposition pour ce niveau sont donc :

| Approximations | Details |

|---|---|

133.25, 163.75 |

58.25, 38.75 |

Avec nos dernières valeurs d'approximations, pouvons-nous encore décomposer ?

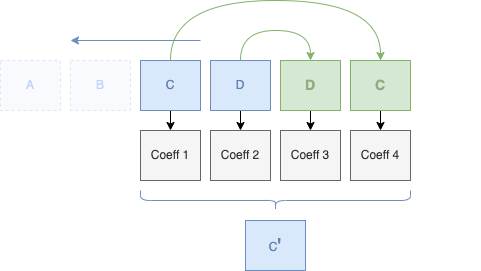

Bien évidemment, nous avons encore un couple de valeurs (133.25, 163.75) que nous pouvons de nouveau décomposer :

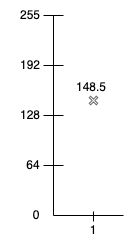

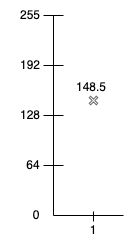

Approximation n°1 : (133.25 + 163.75) / 2 = 148.5

Et notre coefficient de détail :

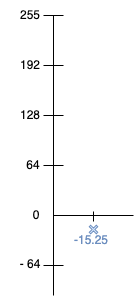

Detail n°1 : (148.5 - 163.75) = -15.25 ou (133.25 - 163.75) / 2 = -15.25

Et de nouveau sur un graphe :

|

|

| Coefficients Approximations | Coefficients Détails |

|---|

Nous n'avons plus de couple de coefficients d'approximations, il ne reste plus qu'une valeur dans notre approximation, nous pouvons donc nous arrêter :

| Approximations | Details |

|---|---|

148.5 |

-15.25 |

Vous ne remarquez pas quelque chose ? Notre graphe de coefficients d'approximations ne contient plus qu'une seule valeur, alors qu'au début, nous avions 8 valeurs. Nous venons de compresser (indirectement) notre signal !

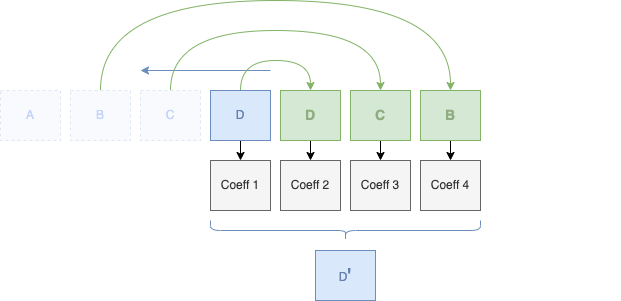

Lorsque nous arrivons à ne plus pouvoir décomposer, nous avons maintenant notre décomposition totale en intégrant notre coefficient d'approximation et nos différents coefficients de détails que nous avons calculés dans les différentes étapes de notre décomposition :

|

|

| Coefficient Approximation | Coefficients Détails |

|---|

Car oui, il est important de conserver les différents coefficients de détail que nous avons calculé aux différentes étapes. Les autres coefficients d'approximations peuvent être oubliés, on ne conservera que le dernier, l'unique. C'est par lui que nous pouvons - et à l'aide des différents coefficients de détails - reconstruire les autres coefficients d'approximations des différents niveaux.

L'avantage de cette méthode, c'est que nous avons - dans un seul signal - l'ensemble des résolutions possibles !

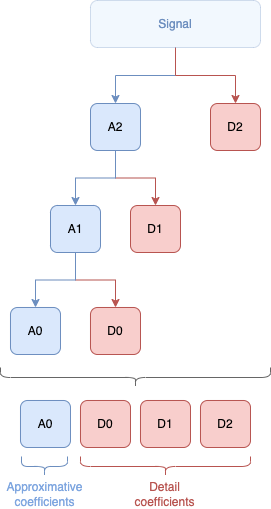

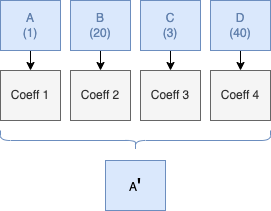

Voici ce que nous avons fait en une seule image :

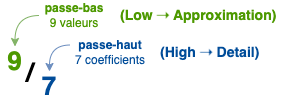

À la fin, nous arrivons donc avec 1 seul coefficient d'approximation et 7 coefficients de détail.

Visuellement, voici la cascade de nos différents calculs et la conservation des coefficients de détail à travers les différents niveaux de décomposition :

Chaque groupe de coefficients de détail représentent un niveau de décomposition qui va nous permettre de retrouver l'ensemble de nos niveaux de décomposition, nos différentes résolutions.

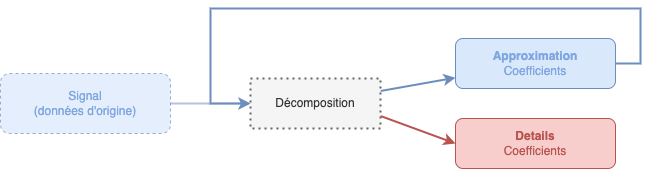

De manière simplifiée, nous avons effectué cette boucle jusqu'à ne plus avoir de données à décomposer, tout en mettant de côté les coefficients de détails :

À chaque fois que nous passons par le bloc de décomposition, nous passons à un nouveau niveau de résolution.

À chaque niveau de décomposition, nous conservons les coefficients de détails précédents. À l'aide de ces schémas représentant nos précédents calculs, nous voyons les différentes étapes de la décomposition totale :

| Schéma en étage | Schéma en arbre | Schéma chiffré |

|---|---|---|

|

|

|

Vous retrouverez un petit programme en Python - écrit à l'arrache - en utilisant cette décomposition simple 1D pour vous amuser :

# ./wavelet_base_1D.fromscratch.py

Using Wavelet 1/2

input=[128, 255, 50, 100, 200, 50, 150, 255]

================= 1st decomposition ==================================

191.5, 75.0, 125.0, 202.5 -63.5, -25.0, 75.0, -52.5

'------- approx --------' '---- detail ------------'

================= 2nd decomposition ==================================

133.25, 163.75 58.25, -38.75, -63.5, -25.0, 75.0, -52.5

'-- approx --' '-------------- detail -----------------'

================= 3rd decomposition ==================================

148.5 -15.25, 58.25, -38.75, -63.5, -25.0, 75.0, -52.5

'-A-' '-------------------- detail ------------------'

Dans ce paragraphe, notre exemple était une simple décomposition 1D avec très peu de données et sans utiliser l'ensemble des paramètres et fonctions constituant les ondelettes. Dans l'ensemble, si vous avez déjà compris cette vulgarisation, vous avez une idée générale et très simplifiée de la base du concept des ondelettes.

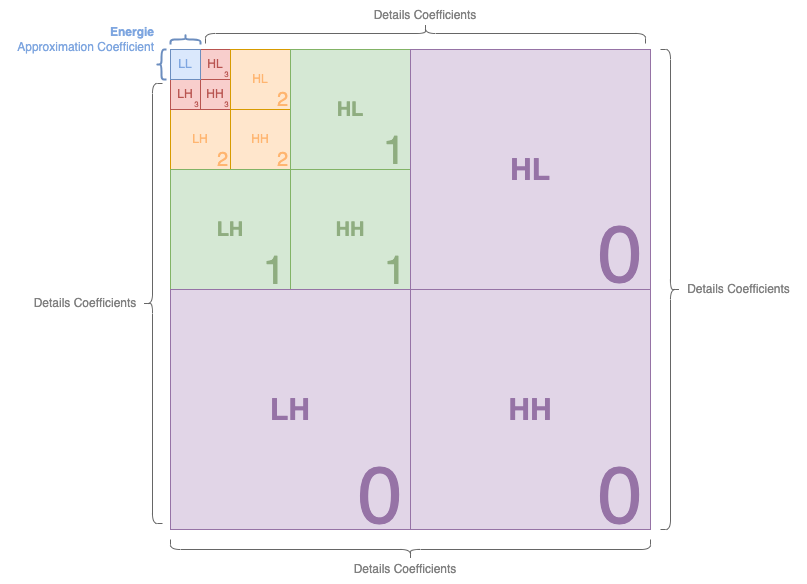

Pour résumer, le coefficient d'approximation est le coeur de notre structure, on le surnomme parfois "énergie" car c'est par lui - ce point de départ - et à l'aide des différents coefficients de détail - que nous pourrons reconstruire les différentes données aux différents paliers (ou résolutions) et à la fin, reconstruire les données d'origine.

Notez ici que je ne parle que d'un coefficient d'approximation, mais selon la quantité de données et le niveau de décomposition, nous aurons une multitude de coefficients d'approximation.

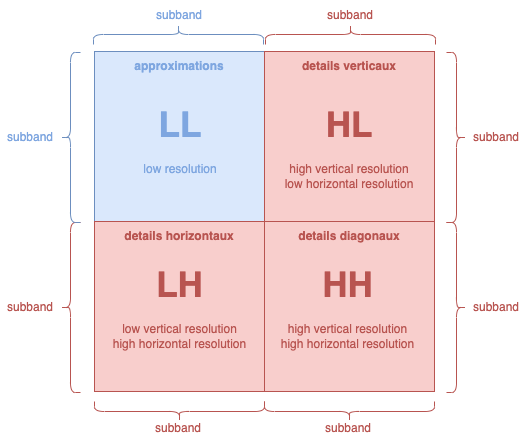

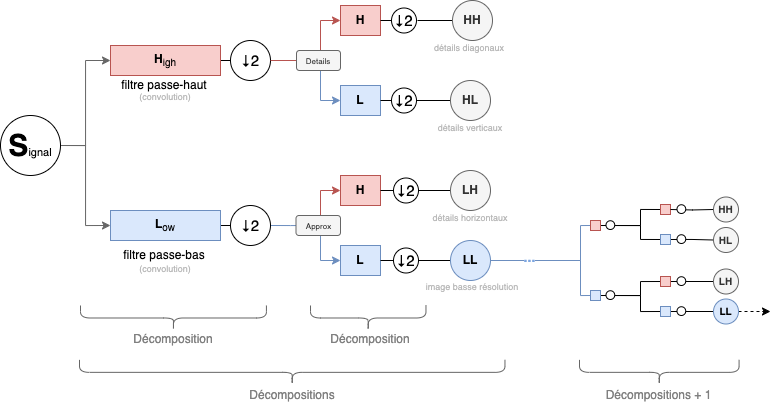

Maintenant que nous avons vu une décomposition simple 1D, voyons une décomposition simple en 2D.

Précédemment, nous avons vu une décomposition en 1D et nous avions besoin d'au moins 2 valeurs.

Maintenant, avec une décomposition en 2D, nous avons un doublement des valeurs, nous aurons donc 2x2 valeurs. Ce bloc de données est appelé une matrice :

Nous allons appliquer des calculs sur cette matrice de 4 valeurs. Tout comme notre décomposition en 1D (2 valeurs) qui générait une décomposition avec 2 autres valeurs (1 approximation + 1 détail), notre matrice de départ en 2D va générer une matrice de décomposition en 2D :

Vous remarquerez que dans la matrice de coefficients, nous avons deux différentes lettres - A et D - qui représentent respectivement notre coefficient d'approximation et nos coefficients de détail.

Nous allons voir maintenant, avec nos données en 2D, comment nous allons arriver à nos différents coefficients. Pour cela, nous allons devoir appliquer notre méthode de calcul pour un environnement en 2D :

A l'aide des valeurs a, b, c et d, nous allons produire une valeur d'approximation (A) pour l'ensemble du bloc et également trois valeurs de détail (D).

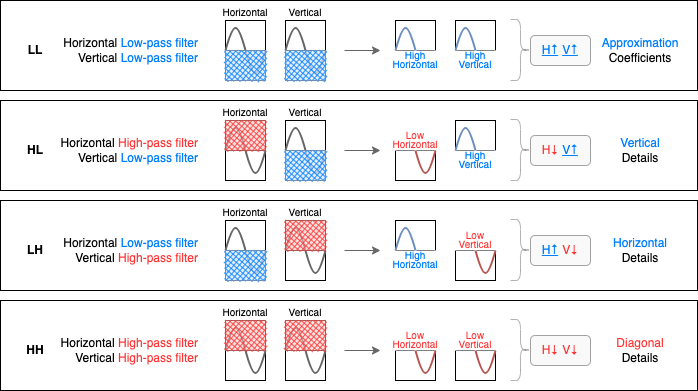

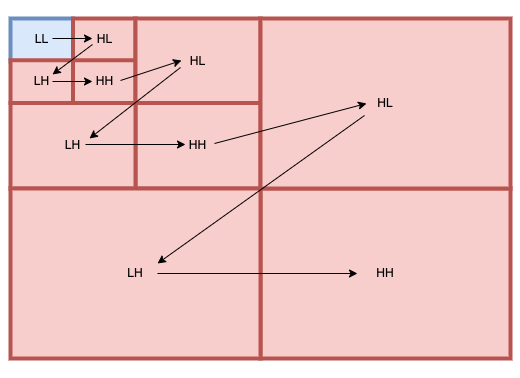

L'ensemble de ces valeurs sont surnommés respectivement LL, HL, LH et HH. Ces blocs sont appelés sous-bandes ou subbands.

| Acronyme | Description | Nom |

|---|---|---|

| LL | Low-Low Resolution - Approximation - Basse Résolution | Approximation |

| HL | High vertical resolution / Low horizontal resolution | Details Verticaux |

| LH | Low vertical resolution / High horizontal resolution | Details Horizontaux |

| HH | High-High Resolution | Details Diagonaux |

Vous retrouverez beaucoup ces acronymes et noms dans les différentes documentations sur le JPEG2000.

Notez que - selon les implémentations - LL, HL, LH et HH peuvent se retrouver à différents endroits, dont voici les principales dispositions les plus couramment observées :

Dans le cadre du JPEG2000, nous serons dans cette disposition :

Dans le cadre de notre chapitre, nous utiliserons cette disposition et une inversion entre HL et LH également (juste parce que certains programmes et librairies l'utilisent, mais le JPEG2000 reste avec un HL à droite).

Pour calculer les différents coefficients, voici les différentes équations possibles pour obtenir LL, LH, HL et HH :

| Zone | Calcul | Représentation graphique |

|---|---|---|

|

LL (Approximation) |

( (a+b) + (c+d) ) / 2 |

|

|

LH (Detail Horizontal) |

( (a+b) - (c+d) ) / 2 |

|

|

HL (Detail Vertical) |

( (a+c) - (b+d) ) / 2 |

|

|

HH (Detail Diagonal) |

( (a-b) - (c-d) ) / 2 |

|

Pour LL (Approximation), rien de bien compliqué, comme pour la version 1D, nous additionnons toutes les valeurs et divisons par 2 pour obtenir une valeur moyenne.

Pour LH (Detail Horizontal), nous allons additionner les deux valeurs horizontalement, les soustraitent entre elles.

Pour HL (Detail Vertical), nous effectuons l'exact opposé de l'équation LH : nous allons additionner les deux valeurs verticalement.

Pour HH (Detail Diagonal), l'équation est l'exact opposé de l'équation pour LL, nous allons tout soustraire.

À partir de là, on va calculer chaque bloc de 2x2 de nos données, et placer les résultats dans les subbands LL, HL, LH ou HH (les sens et les emplacements peuvent changer entre HL et LH). Ici, nous avons neufs blocs de 2x2 pour notre exemple :

À la fin, nous aurons cette nouvelle matrice :

Cette matrice est notre premier niveau de décomposition :

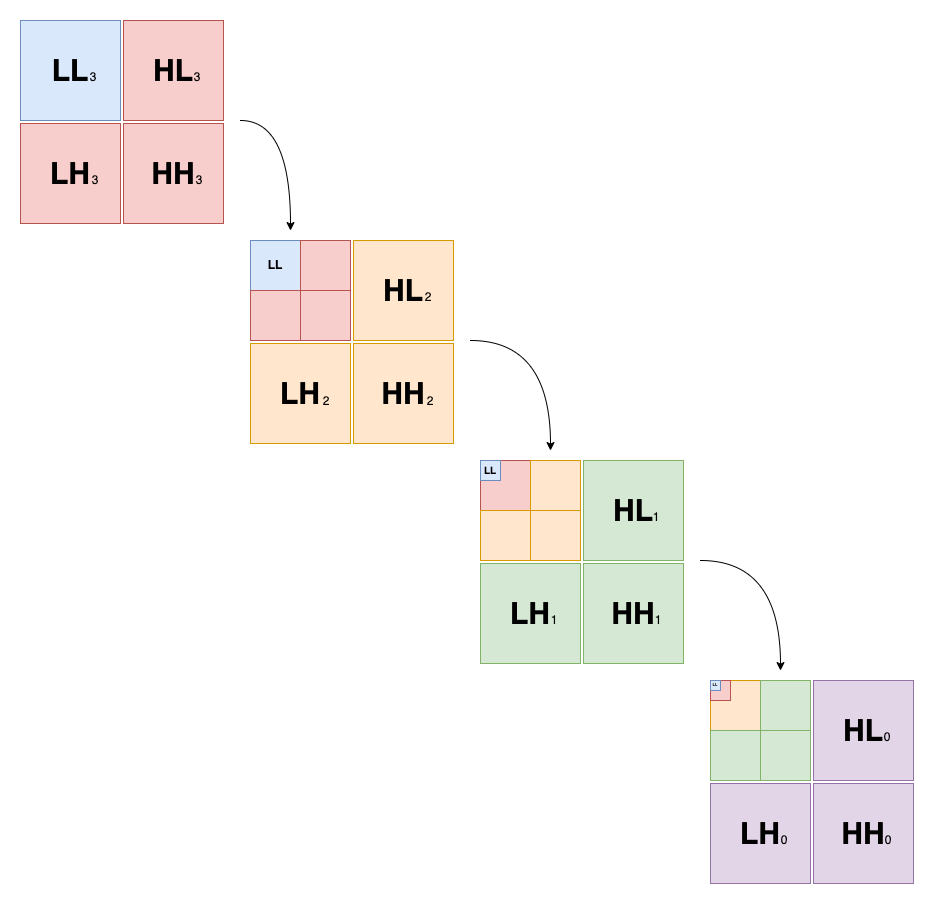

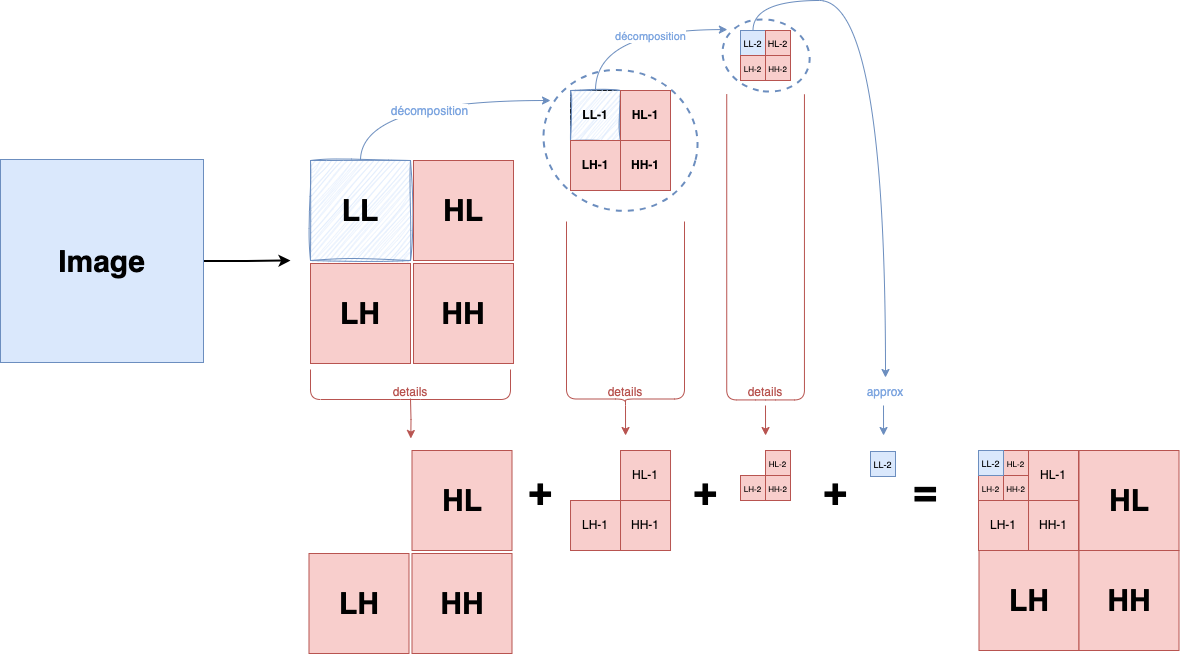

Nous pouvons continuer à décomposer afin d'obtenir une hiérarchie comme telle :

Chaque nouvelle décomposition devient le nouveau LL pour la prochaine étape. Attention, le LL d'un niveau n'est pas conservé dans l'image finale, on ne conservera que le tout-petit LL final.

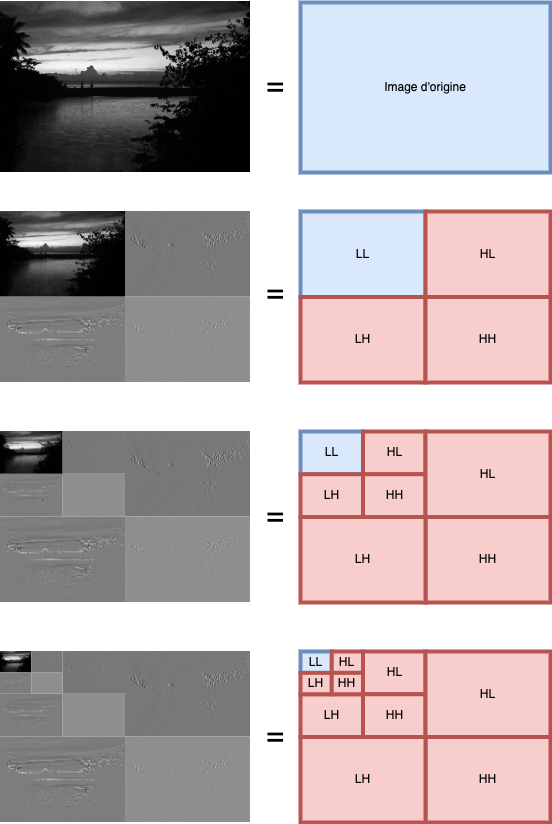

Voyons les différentes étapes une à une :

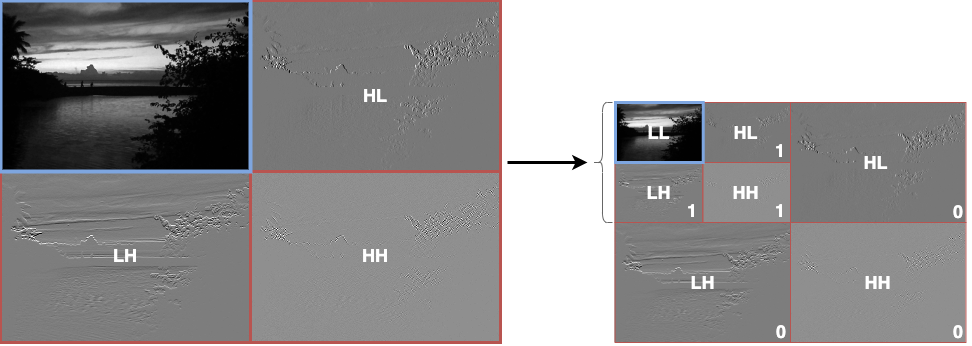

Nous partons de notre image, on va décomposer pour obtenir les subbands

À la fin, nous obtiendrons un résultat de la sorte :

Avec une image, nous obtiendrons ceci :

Votre JPEG2000 ressemblera à une suite de subbands (LL, HL, LH, HH) en cascade dont chaque niveau représente une nouvelle résolution.

Et étape par étape :

Si vous voulez vous amuser, un programme (aussi écrit rapidement, le but étant de comprendre sans avoir une masse de code) vous permet d'effectuer un premier niveau de décomposition en 2D (seulement une matrice 2x2) :

# ./wavelet_haar_2D.py

====== Signal ======

[15, 35]

[45, 75]

-------------------

| | |

| A/LL | H/LH |

| | |

-------------------

| | |

| V/HL | D/HH |

| | |

-------------------

====== From pywt ======

LL : 85.000000

LH : -35.000000

HL : -25.000000

HH : 5.000000

====== From scratch ======

LL : 85.000000

LH : -35.000000

HL : -25.000000

HH : 5.000000

Ainsi qu'un programme pour générer les différentes images représentant LL, HL, LH et HH :

Using external data from data.gray.png

Display input data

0.14117648 0.14117648 0.13725491 0.13725491 0.13725491 0.13725491

0.14901961 0.14509805 0.14117648 0.14117648 0.14117648 0.13725491

(...)

Display wavelet output

LL=

[ 0.27254903 0.26862746 0.27254903 ... 0.07647058 0.0490196 0.01960784 ] ...

[ 0.00784314 0.00784314 0.00784314 ... 0.00784314 0.00784314 0.00784314 ] ...

LH=

[ 0.00980392 0.00588236 0.00196079 ... -0.00588235 0.01372549 0.00784314] ...

[ 0. 0. 0. ... 0. 0. 0. ] ...

HL=

[ 1.9607693e-03 -1.9607842e-03 -1.9607842e-03 ... 5.8823489e-03 5.8823526e-03 7.8431368e-03 ] ...

[ 0.0000000e+00 0.0000000e+00 0.0000000e+00 ... 0.0000000e+00 0.0000000e+00 0.0000000e+00 ] ...

HH=

[ 1.9607879e-03 5.1222742e-09 3.9215693e-03 ... 1.9607833e-03 1.9607847e-03 5.8823526e-03 ] ...

[ 0.0000000e+00 0.0000000e+00 0.0000000e+00 ... 0.0000000e+00 0.0000000e+00 0.0000000e+00 ] ...

Save wavelet output to png

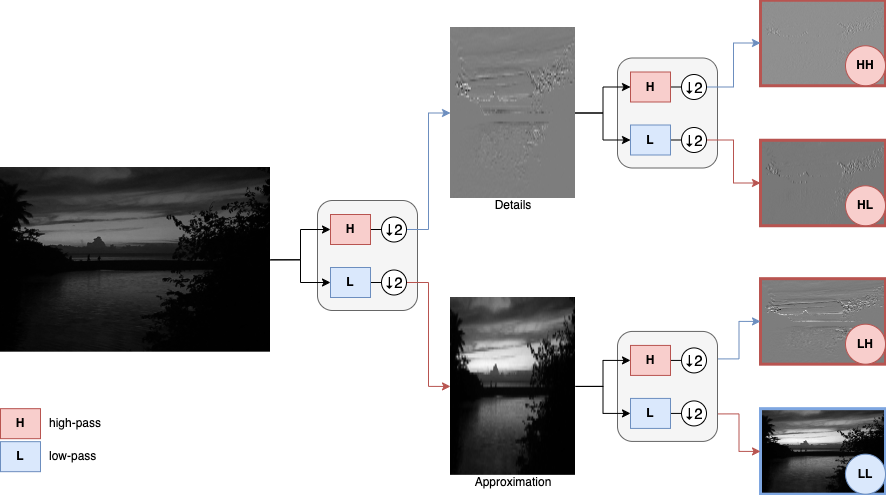

A partir de votre image d'entrée (en noir & blanc), vous obtiendrez 3 images pour LL, LH, HL, et HH.

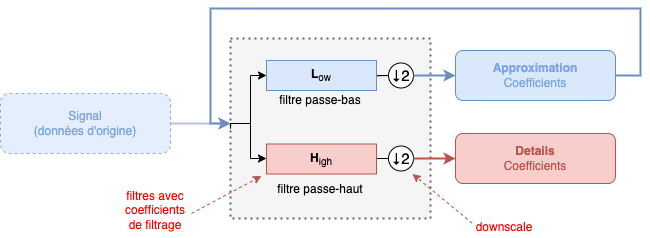

Si vous vous souvenez, nous évoquions rapidement l'utilisation de « fonctions », « filtrages » et autres « downscaling ».

Les ondelettes utilisent deux types de "fonctions" : Scaling et Wavelet. Les deux travaillent de pair pour décomposer ou recomposer une image et travaillent chacune à un certains moments pour générer un certain type de données :

| Nom de la fonction | Surnom | Type d'output | Utilisation | Code | Symbole |

|---|---|---|---|---|---|

| Father | Filtre Passe-Bas | L | φ | ||

| Mother | Filtre Passe-Haut | H | ψ |

Ces éléments, nous les avons déjà vu dans les paragraphes suivants ... mais ils étaient tellement bien cachés que vous êtes passés par-dessus, mais vous les avez bien vu :-) :

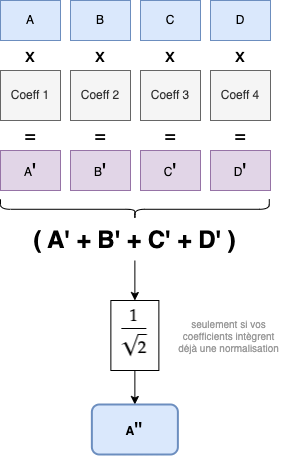

Si nous développons un peu la partie "Décomposition", nous trouverons nos différents éléments :

Quand nous calculions la moyenne de deux valeurs pour avoir le

Notez que la séparation - entre Low et High - ne réprésente pas une division par deux de notre signal, mais seulement que le même signal va passer autant dans Low que dans High. Par exemple, si notre signal a une valeur de 1, ce chiffre va passer dans Low et dans High.

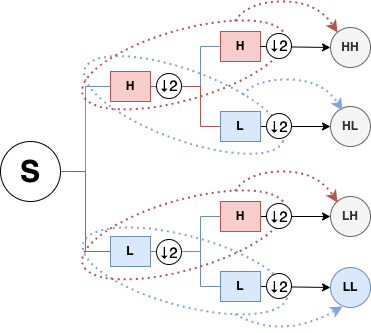

Voici l'exemple du workflow complet d'une seule décomposition en 2D sur des données d'une image, et comment s'articulent les différentes passes de décomposition avec les différents filtres et downscaling (⇣2) :

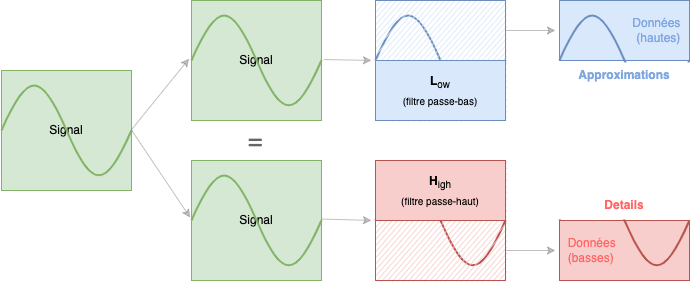

Les filtres "high-pass" coupent les basses fréquences. Les filtres "low-pass" coupent les hautes fréquences. Dit indirectement, les high-pass conservent les hautes-fréquences et les low-pass conservent les basses-fréquences.

Concrètement, nous passons nos données dans notre filtre low-pass, nous obtenons nos coefficients d'approximations. Et avec le même input, nous le passons dans notre filtre high-pass et nous obtenons nos coefficients de détails.

| Les |

|

| Les |

La première phase est notre première résolution. Dès que nous avons réussi à générer le LL d'une résolution plus basse, nous recommençons sa décomposition pour produire une résolution plus basse encore, et ainsi de suite.

Pour comprendre le choix des acronymes LL, LH, HL et HH, il suffit d'entourer les bonnes cases des filtres :)

Avec une image, voyons concrètement les transformations effectuées :

Avec notre petite équation, notre décomposition est relativement simple. Cependant, avec les autres familles d'ondelettes, l'équation de filtrage devient un peu plus compliquée. Les équations deviennent plus complexes car elles intègrent des coefficients de filtrages plus complexes, plus longs.

Pour comprendre le concept des coefficients de filtrages, voyons cela dans le paragraphe suivant.

Revenons un petit moment sur les termes LL, HL, LH et HH représentant les différents subbands que nous retrouverons dans notre encodage JPEG2000.

Dans plusieurs documentations, pour parler les subbands LL, HL, LH et HH, on va vous parler de Horizontal Low-pass filter, Vertical High-pass filter, Vertical Details, Horizontal Details, etc... Dans le flot, vous pouvez être perdu. Et cela serait totalement compréhensible vu le peu d'explication trouvable qui font liens entre tous ces termes.

Pour bien comprendre le lien entre eux, nous allons visualiser les différents types de subbands par type de filtrage et leurs résultats en sortie de filtres :

Les lettres H et L représente respectivement les mots High et Low. Ils sont dans un certain ordre (HH ou HL ou LH ou LL) car ils indiquent le type de filtre que nous allons appliquer respectivement sur les données en Horizontal et en Vertical.

Ainsi, le HL a un filtre Horizontal High-pass et un filtre Vertical Low-pass, et contrairement à ce que le mot pass laisse supposer, ils ne laissent pas du tout passer, ils filtrent :

High-pass filter : Nous allons supprimer toutes les données hautes.

Low-pass filter : Nous allons supprimer toutes les données basses.

En sortie, nous n'aurons plus que des données basses pour l'Horizontal et des données hautes pour le Vertical. Notre HL en sortie de filtre représente surtout des données verticales car ce sont les seules données qui seront hautes en sortie de filtres.

Voici un tableau récapitulatif entre les différents subbands :

| Name | Filtering | Resolution | Wavelet Coefficients Type | |

|---|---|---|---|---|

| LL | Low - Low | Horizontal Vertical |

||

| HL | High - Low | Horizontal Vertical |

||

| LH | Low - High | Horizontal Vertical |

||

| HH | High - High | Horizontal Vertical |

Diagonal Details |

Pour comprendre le lien entre le filtre et ses coefficients, c'est - toute raison gardée - la même qu'une console de jeux-vidéo et les cartouches qu'on y insère. La console étant le filtre et la cartouche étant les coefficients. La cartouche va "transformer" le comportement de la console et afficher différents éléments. Les coefficients de filtrage jouent un peu le même rôle, ils vont influencer les filtres passe-haut et passe-bas.

Les coefficients de filtrages sont les éléments importants des ondelettes, elles seront intégrées dans les blocs - des filtres - "high-pass" et "low-pass".

Dans notre premier exemple, les filtres passe-bas et passe-haut sont relativement simples :

Approx = L(ow) = ( A + B ) / 2 <-- low-pass

Detail = H(igh) = ( A - B ) / 2 <-- high-pass

'---.---' '-'

| |

low/high-pass '-- downscaling ↓

Dans ce dernier, nous n'avons pas de coefficient de filtrage (sauf si on considère que notre coefficient de filtrage est de 1 :)

Par exemple, l'ondelette de type "Haar" (la forme la plus simple des ondelettes) utilise comme coefficient de filtrage passe-bas et passe-haut, la racine carrée de 2 :

Approx = ( (A + B) * sqrt(2) ) / 2 <-- low-pass

Detail = ( (A - B) * sqrt(2) ) / 2 <-- high-pass

'---------.----|----' '-'

| | |

low/high-pass | '-- downscaling ↓

|

coeff. filter

Avec les autres familles, les coefficients de filtrages deviennent beaucoup plus complexes et nous aurons des équations plus longues.

Sur de nombreux sites évoquant les wavelets, dans les bases de données, dans les programmes ou même les librairies, les coefficients sont très souvent réduits sous une forme simple d'une suite de chiffres (qui semblent n'avoir pas beaucoup de sens sans l'équation de base).

Par exemple, avec l'ondelette de Haar, au lieu d'intégrer une équation avec le calcul de sa racine-carré, nous pourrons retrouver un simple 0.70710678118654752440 pouvant être décliné sous différents aspects :

Cette utilisation particulière de la racine-carré de 2 s'explique par le fait d'intégrer directement le downscaling (⇣2) dans l'équation. On va diviser directement la racine-carré de 2 par 2. Avec cette astuce, il nous suffit plus que d'appliquer ce chiffre à notre valeur de données.

Ainsi, si nous devions appliquer un filtre passe-haut à une valeur de données « 5 », toutes ces équations sont équivalentes :

Vous pourrez donc trouver sur certains endroits, différentes implémentations des différentes équations des filtres, selon l'humeur de l'auteur :)

Cela garde un intérêt durant les phases de calcul, il est plus simple pour un ordinateur de faire de simples calculs de base (multiplication, addition, soustraction) que de se faire à chaque fois tous les calculs des équations complexes.

N'oubliez jamais que certains coefficients peuvent prendre en compte un petit sqrt(2) dans leurs équations afin d'obtenir leurs valeurs finales. Cette utilisation de sqrt(2) est appelée normalisation des outputs.

Maintenant que nous avons vu rapidement le principe des coefficients de filtrages, nous allons essayer d'effectuer un calcul avec la wavelet Daubechies-2.

Pour construire nos filtres high-pass et low-pass, on va avoir besoin de nos coefficients de filtrages pour chacun.

Sur le site Wavelet Browser (archive), nous avons ces 8 coefficients pour la décomposition :

| Low-pass | High-pass |

|---|---|

-0.1294095226 |

-0.4829629131 |

0.2241438680 |

0.8365163037 |

0.8365163037 |

-0.2241438680 |

0.4829629131 |

-0.1294095226 |

4 coefficients pour notre filtre low-pass,

4 coefficients pour notre filtre high-pass

Nous pouvons également récupérer ces coefficients via pywt :

import pywt

wavelet = pywt.Wavelet("db2")

# Low-pass (decomposition)

print(*wavelet.dec_lo)

-0.12940952255126037 0.2241438680420134 0.8365163037378079 0.48296291314453416

# High-pass (decomposition)

print(*wavelet.dec_hi)

-0.48296291314453416 0.8365163037378079 -0.2241438680420134 -0.12940952255126037

Vous trouverez également l'ensemble des coefficients de beaucoup de famille d'ondelettes dans ce fichier ou à cette adresse (X)

Sur certaines documentations, vous trouvez également ces valeurs :

-0.1830127, 0.3169873, 1.1830127, 0.6830127

Si c'est le cas, ne paniquez pas, vos coefficients ne sont pas faux, c'est qu'ils intègrent déjà le facteur de normalisation - toujours notre fameux sqrt(2) - et si nous enlevons notre normalisation via un 1/sqrt(2), nous retrouvons les chiffres données par Wavelet Browser et pywt :

-0.1830127 * 1/sqrt(2) = -0.12940952121325926611

0.3169873 * 1/sqrt(2) = 0.22414386938001449608

1.1830127 * 1/sqrt(2) = 0.83651630239980679052

0.6830127 * 1/sqrt(2) = 0.48296291180653302831

Avec pywt, vous retrouverez ces valeurs sous les variables scaling et wavelet :

import pywt

wavelet = pywt.Wavelet("db2")

(phi, psi, x) = wavelet.wavefun(level=1)

# phi = Scaling function

print("Scaling function:", *phi)

Scaling function: 0.0

0.6830127018922194

1.1830127018922194

0.3169872981077807

-0.18301270189221933

0.0

0.0

# psi = Wavelet function

print("Wavelet function:", *psi)

Wavelet function: 0.0

-0.18301270189221933

-0.3169872981077807

1.1830127018922194

-0.6830127018922194

0.0

0.0

Avant de nous lancer la tête la première dans des calculs, débutons notre décomposition en nous basant sur deux méthodes déjà établies : pywt et numpy.

Avec pywt, tout est relativement simple, il suffit de nos données d'entrée (signal) et de définir le type d'ondelette utilisée (db2), pywt se chargera de calculer tout ce qu'il faut pour arriver à la première décomposition à l'aide de dwt() :

import pywt

signal = [1, 20, 3, 40]

coeffs = pywt.dwt(signal, 'db2')

print(*coeffs)

[ 8.13172798, 12.70933969, 43.48706704] <== coefficients approximations Db2

[-11.63507628, -21.4212545 , 22.65778012] <== coefficients details Db2

Et voilà, nous avons notre première décomposition avec Daubechies-2 !

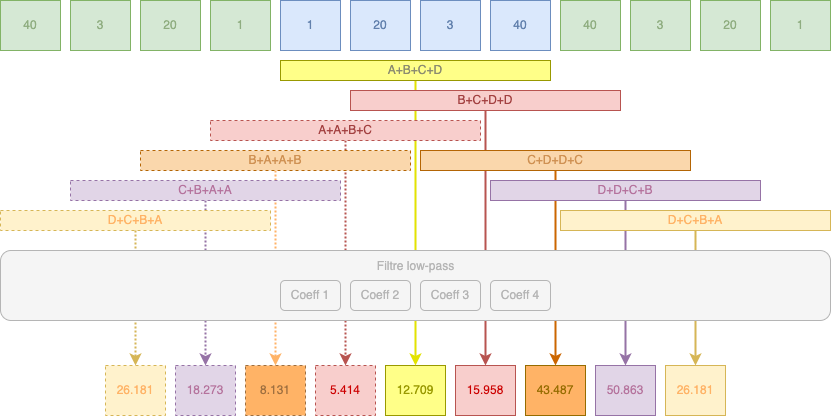

Maintenant, essayons avec numpy, nous pourrons voir les différentes étapes, la convolution (calcul de deux vecteurs), le downscale et la suppression des bordures des données de sortie :

| import numpy as np

|

|

| convolution:

12.70933969

downscale:

12.70933969

clean: |

convolution:

-21.4212545

downscale:

-21.4212545

clean : |

| Approximations | Details |

Et là... c'est le drame, nos valeurs de fin avec numpy ne sont pas les mêmes qu'avec pywt. Si nous regardons bien, nous n'avons que 2 valeurs en commun avec la sortie de pywt. Pourquoi ?

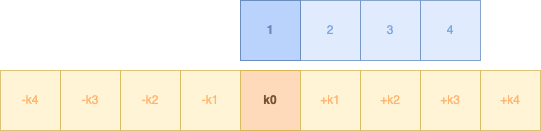

Il faut comprendre un petit principe : avec 4 coefficients de filtrage, nous devons les appliquer avec 4 valeurs de données et pour chacune des données de notre signal.

Je m'explique : nos 4 coefficients de filtrage vont s'appliquer sur nos 4 valeurs afin d'obtenir la première valeur de notre calcul. Mais ce dernier est en rapport avec notre première valeur d'input (ici 1).

Après ce calcul, nous devons donc appliquer ce même mécanisme pour le nombre suivant dans nos données d'entrées (ici 20), donc on va décaler nos données vers la gauche, et ainsi de suite jusqu'à la dernière donnée de notre signal (40).

Cependant, nous avons un souci : si nous décalons nos données, sur quelles données les 4 coefficients de filtrage vont-t-ils s'appliquer en bout de chaîne ?

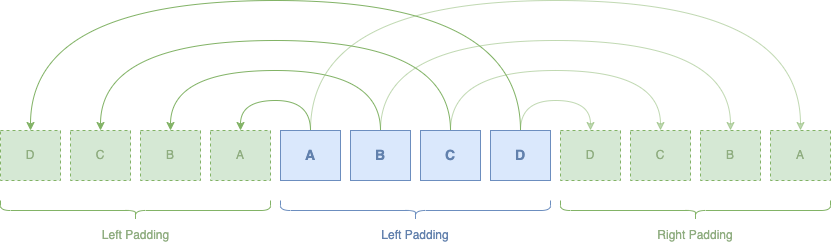

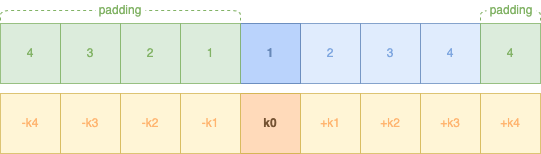

Et c'est là que le principe du padding intervient.

Dans les calculs par ondelettes, si nous n'avons pas assez de données pour appliquer les différents coefficients, nous pouvons appliquer un complément de données appelé padding. Vous avez plusieurs formes de padding :

| Nom | Description |

|---|---|

| Zero Padding | On rajoute des 0 |

| Constant Padding | Les données en bordures sont utilisés comme valeur de référence pour le padding |

| Symmetric Padding | Effet miroir des données initiaux |

| Reflect Padding | Réflexion des données |

| Periodic Padding | Une sorte de replica des données |

| Smooth Padding | Le signal est étendu suivant les premiers calculs |

| Antisymmetric Padding | La même que symmetric mais avec des valeurs négatives |

| Antireflect Padding | Fusion de la méthode antisymmetric et reflect. |

Vous trouverez de plus amples informations à propos des différents paddings sur cette page.

Par défaut, pywt utilise la méthode symmetric et effectue ce travail de padding automatiquement (via l'option mode), c'est à dire qu'il va utiliser les données de votre signal et les répliquer en sens inverse avant de procéder aux différents calculs nécessaires.

Notre signal

Intégrons maintenant notre nouveau signal avec son padding (en vert) dans notre précédent programme :

| convolution:

26.18153328 18.27394916 8.13172798

5.41412801 12.70933969 15.95818099

43.48706704 50.86340983 26.18153328

downscale:

26.18153328 8.13172798 12.70933969

43.48706704 26.18153328

clean: |

convolution:

10.39855066 -4.51755254 -11.63507628

14.92788394 -21.4212545 10.88151357

22.65778012 -21.29184498 10.39855066

downscale:

10.39855066 -11.63507628 -21.4212545

22.65778012 10.39855066]

clean : |

| Approximations | Details |

Et voilà ! nos coefficients d'approximations et de détails sont équivalents à ceux de pywt !

Maintenant que nous avons vu comment utiliser l'ondelette Daubechies-2 avec pywt et numpy, effectuons nous-même nos propres caluls sans aucune librairie.

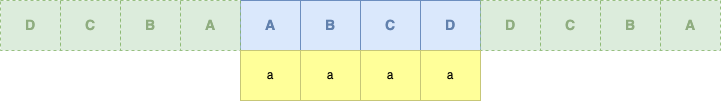

Tout d'abord, nous allons regrouper nos différents groupes de données qui vont nous servir, en incluant les paddings :

| Middle | |

|---|---|

|

|

| Left Padding | Right Padding |

|

|

Vous voyez nos différents groupes de données avec qui nous allons appliquer nos 4 coefficients de décomposition high-pass ou low-pass.

Pour les récupérer, nous allons directement utiliser les fonctions scaling et wavelet qui vont nous donner (aussi) les coefficients pour le high-pass et low-pass :

import pywt

# on récupère les propriétés de Db2

wavelet = pywt.Wavelet("db2")

(phi, psi, x) = wavelet.wavefun(level=1)

# Scaling function (hi->approximation) (phi) :

0.0 0.6830127018922194 1.1830127018922194 0.3169872981077807 -0.18301270189221933 0.0 0.0

# Wavelet function (lo->detail) (psi) :

0.0 -0.18301270189221933 -0.3169872981077807 1.1830127018922194 -0.6830127018922194 0.0 0.0

Maintenant que nous avons nos coefficients de scaling (0.68, 1.18, 0.31, -0.18), qui va nous servir pour le filtre high-pass, nous pouvons effectuer le calcul, il suffit de multiplier chaque donnée avec son coefficient attitré :

# Rappel des coefficients de filtrage :

# 0.6830127018922194 1.1830127018922194 0.3169872981077807 -0.18301270189221933

1 * 0.6830127018922194 = 0.6830127018922194

20 * 1.1830127018922194 = 23.6602540378443880

3 * 0.3169872981077807 = 0.9509618943233421

40 * -0.18301270189221933 = -7.32050807568877320

Puis, nous additionnions toutes les valeurs :

0.6830127018922194 + 23.6602540378443880 + 0.9509618943233421 + -7.32050807568877320 = 17.97372055837117630

Ah... nous avons pas la même valeur. Normalement, nous devrions avoir 12.70933969. Il nous manque un petit calcul, celui avec le coefficient de normalisation :

17.97372055837117630 * 1/sqrt(2) = 12.70933968997631815112

Voila notre premier coefficient d'approximation pour notre séquence initiale [1, 20, 3, 40] et maintenant, nous devons effectuer les calculs pour l'ensemble des séquences :

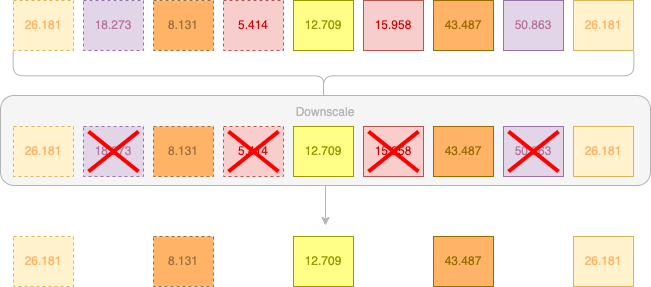

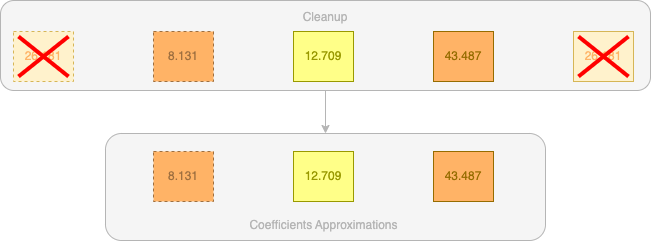

Maintenant que nous avons nos différents coefficients, nous devons procéder à un downscale. Précédemment, notre downscale était implicite, nous additionnons nos deux valeurs et appliquions une division et donc nous conservions qu'une seule valeur. Ici, avec nos coefficients, le downscale n'est pas une division, mais carrément une suppression d'une valeur des deux valeurs pour n'en conserver une seule :

Nos valeurs intermédiaires sont donc 26.181, 8.131, 12.709, 43.487 et 26.181.

Maintenant, nous allons appliquer un cleanup, nous allons supprimer les deux valeurs de bords car elles nous sont maintenant inutiles :

Et voila !

Nous avons notre première décomposition pour nos coefficients d'approximation. Maintenant, nous devons effectuer la même chose avec les coefficients de scaling (ou high-pass) pour les obtenir.

À la fin, vous vous retrouverez avec ces valeurs :

| Approximations | Details |

|---|---|

8.13172798 12.70933969 43.48706704 |

-11.63507628 -21.4212545 22.65778012 |

Vous venez de faire votre premier calcul de décomposition avec les wavelets Daubechies-2 à l'aide des filtres passe-haut et passe-bas et leurs coefficients low-pass (scaling function) et leurs coefficients high-pass (wavelet function).

Vous retrouverez un programme utilisant ce principe à cette adresse. Le programme vous montre une décomposition Debauchies-2 avec les méthodes pywt, numpy et from-scratch.

Maintenant que nous avons vu cela, nous pouvons nous attaquer aux ondelettes utilisées dans le JPEG2000 : Daubechies 9/7 (surnommé parfois CDF 9/7) et LeGall 5/3 (surnommé parfois LGT 5/3).

Le JPEG2000 possède plusieurs profils, ce sont des méthodes d'utilisation.

Pour un DCP, c'est le profil irréversible qui a été choisi, ce profil indique une utilisation de la compression avec pertes.

Cela veut dire que le fichier qui sortira après la compression ne pourra pas retourner à son fichier d'origine, vous aurez perdu de la matière pour les besoins de la compression ( à contrario d'une compression sans perte qui permet de retrouver le fichier d'origine, un exemple avec une compression ZIP : votre fichier est compressé mais en le décompressant, vous retrouvez le fichier d'origine).

Le JPEG2000 peut être utilisé sans pertes, c'est le profil réversible qui permettrait de retrouver le fichier d'origine. Ce choix a été fait uniquement pour le format d'échange et de préservation IMF, et non le DCP.

Le JPEG2000 utilise deux wavelets différentes : Daubechies 9/7 et LeGall 5/3 :

LeGall 5/3 est utilisé pour de la compression réversible.

Daubechies 9/7 est utilisé pour de la compression irréversible.

Les deux types de wavelets auront des coefficients différents et également des coefficients différents entre passe-bas et passe-haut.

Pour le JPEG2000 DCP, nous utiliserons Daubechies 9/7.

Avec Daubechies 9/7, nous avons des coefficients passe-haut et passe-bas avec différentes valeurs - et surtout le nombre de coefficients diffère entre les deux filtres :

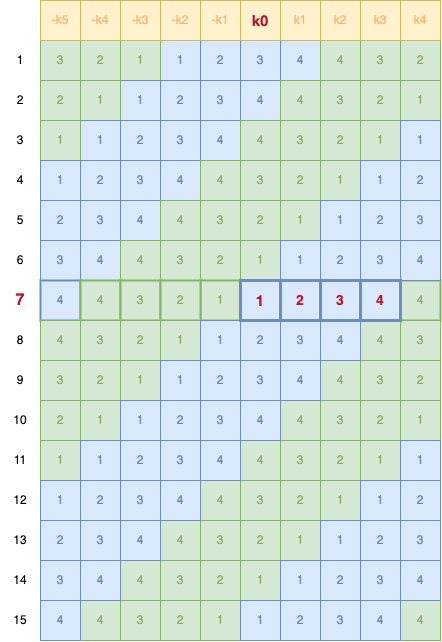

Voici les coefficients Daubechies 9/7 et LeGall 5/3 :

|

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Tout de suite, vous vous dites que vous ne voyez que 5 coefficients et 4 coefficients dans le tableau Daubechies 9/7, alors pourquoi parler de 9/7 ?

Dans la plupart des tableaux, vous verrez une colonne (souvent nommée "k") avec des symboles ±, c'est simplement que la valeur du centre est celle avec k0 et le reste sont des valeurs se trouvant à droite et à gauche de ce centre. Un peu comme un effet miroir dont le centre est k0.

Ainsi, si nous prenons notre tableau, voici notre matrice complète de coefficients (réduites à 3 chiffres après la virgule) :

| Position / Filtre |

> | -4 | -3 | -2 | -1 | 0 | +1 | +2 | +3 | +4 | < |

|---|---|---|---|---|---|---|---|---|---|---|---|

| Low-pass | 0 | +0.026 | -0.016 | -0.078 | +0.266 | +0.602 | +0.266 | -0.078 | -0.016 | +0.026 | 0 |

| High-pass | 0 | +0.000 | +0.091 | -0.057 | -0.591 | +1.115 | -0.591 | -0.057 | +0.091 | +0.000 | 0 |

| middle |

Pywt n'intègre pas (encore) Daubechies 9/7. Pour l'intégrer par nous-même, il suffit d'intégrer nos 4 matrices de coefficients dans une nouvelle classe Wavelet :

# Nos coefficients Daubechies 9/7

dec_low = [0.0, 0.026748757411, -0.016864118443, -0.078223266529, 0.266864118443, 0.602949018236, 0.266864118443, -0.078223266529, -0.016864118443, 0.026748757411]

# ┗━━ middle ━━┛

dec_high = [0.0, 0.091271763114, -0.057543526229, -0.591271763114, 1.11508705, -0.591271763114, -0.057543526229, 0.091271763114, 0.0, 0.0]

# ┗━middle━┛

rec_low = [0.0, -0.091271763114, -0.057543526229, 0.591271763114, 1.11508705, 0.591271763114, -0.057543526229, -0.091271763114, 0.0, 0.0]

# ┗━middle━┛

rec_high = [0.0, 0.026748757411, 0.016864118443, -0.078223266529, -0.266864118443, 0.602949018236, -0.266864118443, -0.078223266529, 0.016864118443, 0.026748757411]

# ┗━━ middle ━━┛

wavelet = pywt.Wavelet(

name='Daubechies CDF 9/7',

filter_bank=(dec_low, dec_high, rec_low, rec_high)

)

wavelet.orthogonal = False

wavelet.biorthogonal = True

print(wavelet)

Wavelet Daubechies CDF 9/7

Family name:

Short name:

Filters length: 10

Orthogonal: False

Biorthogonal: True

Symmetry: unknown

DWT: True

CWT: False

print(*wavelet.dec_lo)

0.0 0.026748757411

-0.016864118443 -0.078223266529

0.266864118443 0.602949018236

0.266864118443 -0.078223266529

-0.016864118443 0.026748757411

print(*wavelet.dec_hi)

0.0 0.091271763114

-0.057543526229 -0.591271763114

1.11508705 -0.591271763114

-0.057543526229 0.091271763114

0.0 0.0

# Récupération des fonctions scaling et wavelet

(phi_decomp, psi_decomp, phi_recomp, psi_recomp, x) = wavelet.wavefun(level=1)

print(*phi_decomp)

0.0 0.03782845550726404 -0.023849465019556843

-0.11062440441843718 0.37740285561283066 0.8526986790088938

0.37740285561283066 -0.11062440441843718 -0.023849465019556843

0.03782845550726404 0.0 0.0

0.0 0.0 0.0

0.0 0.0 0.0

print(*psi_decomp)

0.0 0.0 0.0

-0.1290777652575232 0.08137883521982373 0.8361845464440707

-1.5769712293366058 0.8361845464440707 0.08137883521982373

-0.1290777652575232 0.0 0.0

0.0 0.0 0.0

0.0 0.0 0.0

Avec cela, nous pouvons utiliser pywt pour calculer nos coefficients:

Vous retrouverez dans ce programme avec un calcul approximations et détails avec pywt

Et nous pouvons appliquer cette méthode avec numpy également :

import numpy as np

signal = [1, 2, 3, 4]

wavelet_dec_low = [

0.0,

0.026748757411,

-0.016864118443,

-0.078223266529,

0.266864118443,

0.602949018236,

0.266864118443,

-0.078223266529,

-0.016864118443,

0.026748757411

]

signal_padded = pywt.pad(signal, len(wavelet_dec_low), 'symmetric')

print(signal_padded)

[2 1 1 2 3 4 4 3 2 1 1 2 3 4 4 3 2 1 1 2 3 4 4 3]

# convolution + downscale + cleanup

approximation = np.convolve(signal_padded, wavelet_dec_low, 'valid')[::2][1:-1]

# convolution = 3.0584539885929996 3.891633728893 3.8916337288930007 3.058453988593 1.9415460114070002 1.1083662711070001 1.1083662711070001 1.9415460114069998 3.0584539885929996 3.891633728893 3.8916337288930007 3.058453988593 1.9415460114070002 1.1083662711070001 1.1083662711070001

# downscale = 3.0584539885929996 3.8916337288930007 1.9415460114070002 1.1083662711070001 3.0584539885929996 3.8916337288930007 1.9415460114070002 1.1083662711070001

# final result

print(*approximation)

3.8916337288930007 1.9415460114070002

1.1083662711070001 3.0584539885929996

3.8916337288930007 1.9415460114070002

Il suffit de faire la même chose pour les coefficients de détails avec wavelet_dec_high.

wavelet_dec_high = [

0.0,

0.091271763114,

-0.057543526229,

-0.591271763114,

1.11508705,

-0.591271763114,

-0.057543526229,

0.091271763114,

0.0,

0.0

]

# convolution + downscale + cleanup

detail = np.convolve(signal_padded, wavelet_dec_high, 'valid')[::2][1:-1]

# convolution = 0.3075435163990001 0.3075435163990001 -0.12500000737299982 0.12499999508300005 -0.30754352868899987 -0.30754352868899976 0.12499999508300014 -0.12500000737299938 0.3075435163990001 0.3075435163990001 -0.12500000737299982 0.12499999508300005 -0.30754352868899987 -0.30754352868899976 0.12499999508300014

# downscale = 0.3075435163990001 -0.12500000737299982 -0.30754352868899987 0.12499999508300014 0.3075435163990001 -0.12500000737299982 -0.30754352868899987 0.12499999508300014

# final result

print(*detail)

-0.12500000737299982 -0.30754352868899987

0.12499999508300014 0.3075435163990001

-0.12500000737299982 -0.30754352868899987

Retrouvez la méthode numpy dans ce programme.

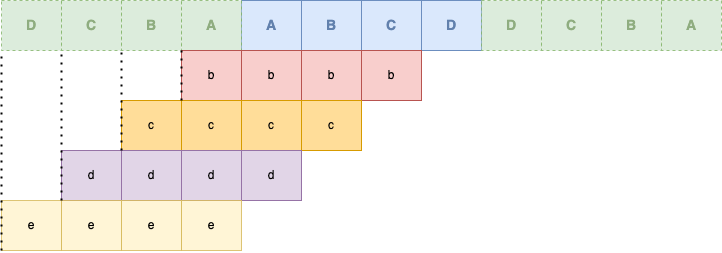

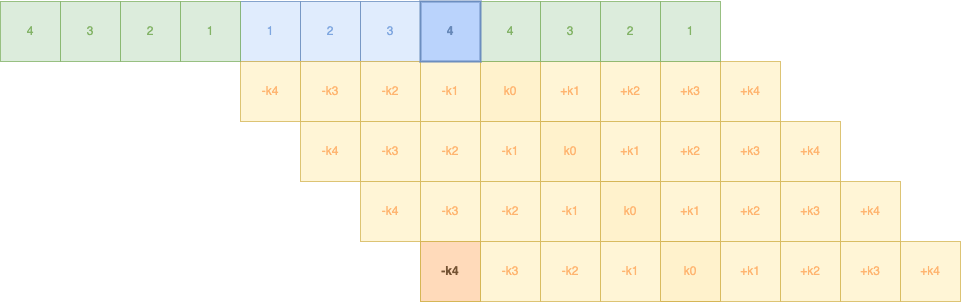

Voyons maintenant notre propre méthode de calcul en commençant par la sortie :

Notre k0 sera appliqué sur la première donnée :

On voit tout de suite le souci : nous n'avons pas assez de donnée à droite comme à gauche. Pour cela, nous appliquons notre méthode de padding (mode symétrie) :

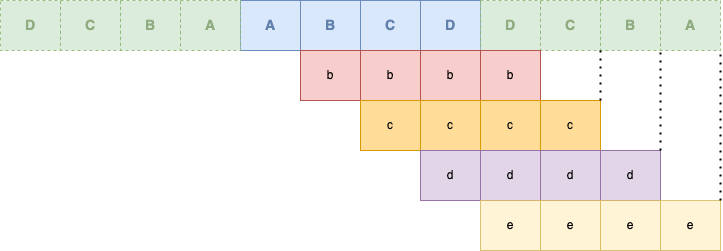

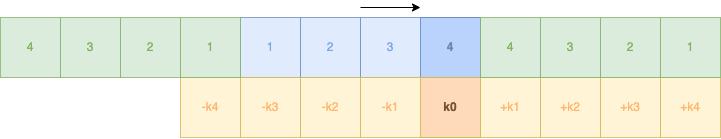

Bien entendu, nous devons appliquer sur l'ensemble de nos 4 données :

A partir de là, nous n'avons pas terminé, si vous remarquez, nous avons encore 4 coefficients en arrière (-k1, -k2, -k3 et -k4). Nous devons arriver à faire passer tous nos coefficients jusqu'à la dernière donnée, donc jusqu'à ce que -k4 puisse côtoyer la donnée 4 :

Et nous effectuons la même chose de l'autre côté.

Un petit détail, nous n'avons pas que 9 coefficients mais 10, le 0.0 supplémentaire, nous aurons donc un -k5, ainsi voici la matrice complète de décalage et de calculs entre coefficients et données :

Pour les calculs, ils sont relativement simples et nous les avons déjà vus :

wavelet_dec_low = [

0.0, # -k5 (notre ajout pour avoir 10 coefficients)

0.026748757411, # -k4

-0.016864118443, # -k3

-0.078223266529, # -k2

0.266864118443, # -k1

0.602949018236, # k0

0.266864118443, # +k1

-0.078223266529, # +k2

-0.016864118443, # +k3

0.026748757411 # +k4

]

a = signal[0] * wavelet_dec_low[0]

b = signal[1] * wavelet_dec_low[1]

c = signal[2] * wavelet_dec_low[2]

d = signal[3] * wavelet_dec_low[3]

e = signal[4] * wavelet_dec_low[4]

f = signal[5] * wavelet_dec_low[5]

g = signal[6] * wavelet_dec_low[6]

h = signal[7] * wavelet_dec_low[7]

i = signal[8] * wavelet_dec_low[8]

j = signal[9] * wavelet_dec_low[9]

print("Approximation :", (a+b+c+d+e+f+g+h+i+j))

Maintenant, prenons notre signal décalé de la ligne 7 (4, 4, 3, 2, 1, 1, 2, 3, 4, 4) et appliquons nos coefficients low-pass :

# S * LowPass

a = 4 * 0.0

b = 4 * 0.026748757411

c = 3 * -0.016864118443

d = 2 * -0.078223266529

e = 1 * 0.266864118443

f = 1 * 0.602949018236

g = 2 * 0.266864118443

h = 3 * -0.078223266529

i = 4 * -0.016864118443

j = 4 * 0.026748757411

Approximation = (a+b+c+d+e+f+g+h+i+j)

Approximation = 1.1083662711070001

Si nous comparons avec notre tableau :

Et pour les coefficients de détails, c'est pareil avec les coefficients high-pass. Notez que nous n'avons pas eu besoin de jouer avec la racine-carré-de-2, les coefficients intègrent déjà ~~tout le bordel~~ tous les calculs sur la normalisation.

Vous retrouverez l'ensemble des calculs bruts dans ce programme.

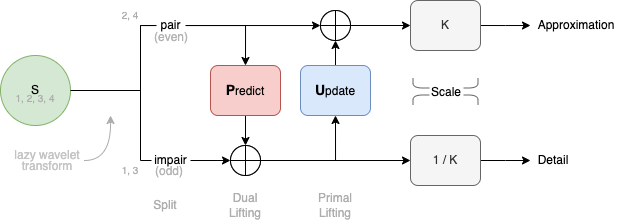

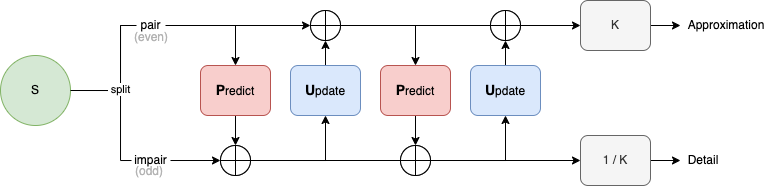

Précédemment, nous avons vu comment effectuer des calculs wavelets via le principe de la convolution. Cependant, il existe une autre méthode, la méthode lifting 1, 2.

Elle diffère par la méthode de calcul, des différentes étapes et surtout des coefficients finaux (mais pas des équations de convolutions à l'origine qui seront retravaillées pour être "traduit" pour devenir la méthode lifting).

La méthode lifting a été développée afin d'accélérer les calculs lors d'une décomposition. Elles ont été développées par Wim Sweldens et Ingrid Daubechies, dès 1996.

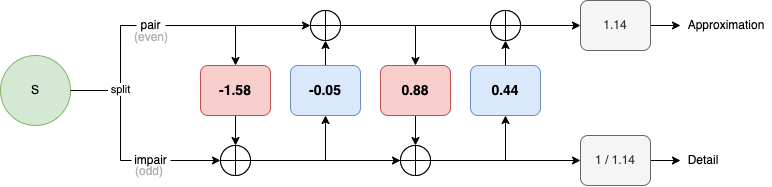

Au lieu d'un ensemble de filtres de coefficients (bank filters), la méthode lifting utilisent des étapes de predicts (prédiction) et d'update : un simple mécanisme de prévision et de mise-à-jour est utilisé dont voici un schéma simplifié 5 :

Cela est accompagné d'un downscale placé en amont des calculs plutôt qu'en aval. Autrement dit, nous effectuons un downscale avant nos filtrages Predict/Update. Cela a un intérêt direct: nos calculs ne s'appliquent plus que sur la moitié des données.

La méthode lifting a aussi un intérêt très concret: Étant plus simple, cette méthode consomme moins de ressources. On parle d'une amélioration allant jusqu'à 80%.

Avec le passage via predicts et update, nos coefficients sont eux aussi moins nombreux, nous passons de 9+7 à seulement 5 coefficients de filtrage. Avec la convolution, nous avons 9 multiplications et 14 additions. Avec la méthode lifting, nous passons à 6 multplications et 8 additions.

L'autre avantage est que l'on peut transformer les différentes ondelettes à filter-banks en version liftée. Ainsi, notre Daubechies 9/7 a été traduit de la sorte pour correspondre à la méthode liftée :

| Etape | Coefficient |

|---|---|

| Predict 1 | -1.586134342059924 |

| Update 1 | -0.052980118572961 |

| Predict 2 | 0.882911075530934 |

| Update 2 | 0.443506852043971 |

| Scale 6 | 1.1496043988602418 |

Vous remarquez qu'il existe deux étapes Predicts et Updates, pour Daubechies, elles seront à la suite juste avant le scale final :

Ce qui donne avec les différentes valeurs :

Pour les équations :

d = odd - P(even)

c = even + U(d)

P étant l'opérateur de Prediction (Dual lifting)

U étant l'opérateur d'Update (Primal lifting)

La méthode Fast Wavelet Transform est la dernière méthode choisie pour les nouveaux DCP SMPTE JPEG2000. Cette méthode permet d'accelérer la compression et la décompresson mutiscale. A l'heure actuelle, la quasi-majorité des décodeurs DCP permettent de lire cette nouvelle méthode, seules quelques très vieux décodeurs DCP peuvent avoir du mal (on parle de quelques flashs lumineux lors de lectures).

Le HTJ2K est une évolution de l'encodage JPEG2000 qui permet d'améliorer ces performances. Le HTJ2K s'attaque essentiellement à la partie arithmétique du block coder. Pour l'instant, cette méthode est surtout orientée pour l'IMF, mais il est prévu que cette évolution arrive aussi pour la projection donc dans les DCP.

Le JPEG2000 dans un DCP est normé par ces différentes publications :

SMPTE 429-2-2013 - DCP Operational Constraints, Chapitre Compression

ISO/IEC 15444-1 - JPEG 2000 Image Coding System — Part 1: Core Coding System

ISO/IEC 15444-1 - Amd 1:2006 - Profiles for Digital Cinema Applications

Voici les principaux critères du JPEG2000 utilisé dans le cinéma numérique :

| D-Cinema | ||

|---|---|---|

| Pertes | Avec pertes | |

| Bitdepth | 12 bits 12 bits par composant 12 x 3 = 36 bits par pixel |

|

| Espace Colorimétrique (Colorspace) |

YCbCr 7 (Input: X'Y'Z') |

YUV |

| Subsample | Non Seulement 4:4:4 |

Seulement 4:4:4 |

| Transformation colorimétrique | ICT (Irreversible Color Transformation) |

(Reversible Color Transformation) |

| Transformation Wavelet | CDF 9/7 Irreversible avec filtres 9/7 Précision minimum: 16 bits fixed point |

Précision minimum: 16 bits fixed point |

| Quantification | Oui | |

| Rate Control | Oui | |

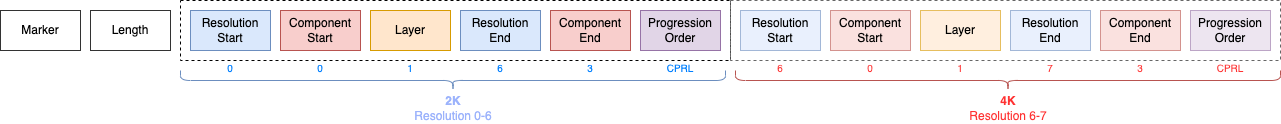

| Progression Order | CPRL (Component Position Resolution Layer) |

Les résolutions valides sont 2048x1080 (2K) et 4096x2160 (4K). Notez que vous aurez des résolutions inférieures de par le principe du JPEG2000 multi-résolutions :

| 2K | 4K |

|---|---|

| 2048 x 1080 | 4096 x 2160 |

| 1024 x 540 | 2048 x 1080 |

| 512 x 270 | 1024 x 540 |

| 256 x 135 | 512 x 270 |

| 128 x 68 | 256 x 135 |

| 128 × 68 |

Il existera donc 6 résolutions, dont 5 décompositions (appelées aussi Wavelet Transformations Levels).

Voir paragraphe Resolutions et Decompositions pour de plus amples informations.

L'image et (l'unique) tile sont collés au bord (0, 0) (donc les positions de décalage XOsiz & YOsiz et les positions de décalage XTOsiz & YTOsiz seront toujours à 0)

La fonctionnalité Region Of Interest (ROI) n'est pas acceptée.

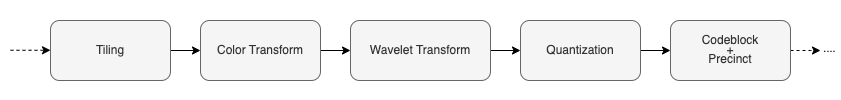

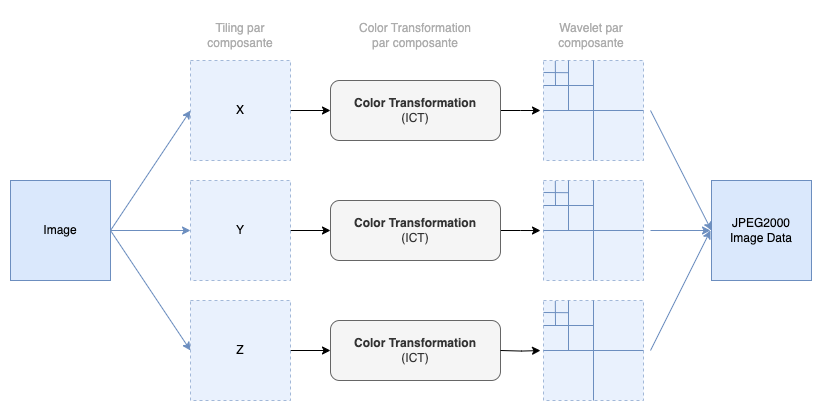

La transformation en JPEG2000 s'effectue par différentes étapes dans cet ordre :

La version complète du workflow JPEG2000 :

| Preprocessing | Core Processing | Bit-Stream |

|---|---|---|

| Tiling | Discrete Wavelet Transformation | Precincts |

| DC-Level Shifting | Quantization | Code-blocks |

| Component Transformation | Entropy Coding | Layers |

| Packets |

Voyons les différentes principales étapes :

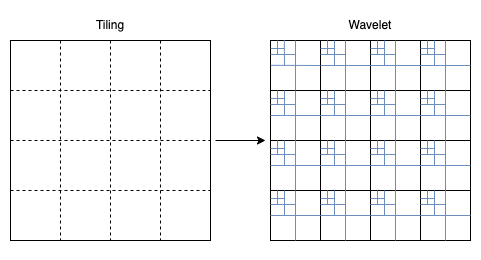

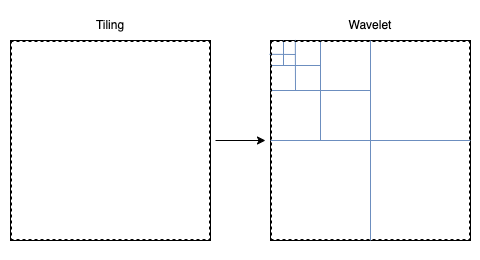

La norme JPEG2000 permet de créer des découpages de l'image qu'on appelle "tiles". Les tiles sont des subdivisions de l'image avant les étapes de transformation colorimétrique et de transformation wavelet. Cela est utile si on travaille sur des systèmes avec peu de ressources (CPU/Ram).

Dans notre cas du JPEG2000 cinéma, cela n'est pas utile, le processus de wavelet effectuera son travail sur l'entièreté de l'image, l'image n'a qu'une seule Tile :

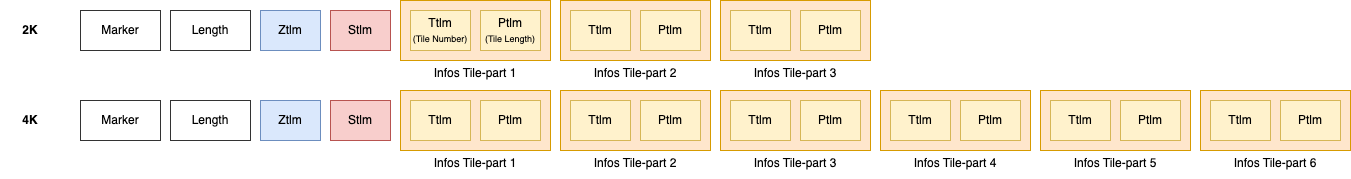

Il existe cependant une petite subtilité si nous prenons les spécifications DCI :

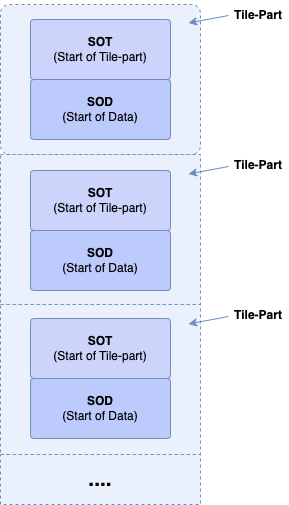

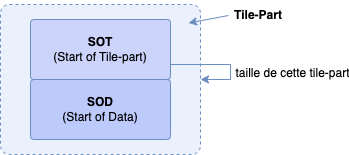

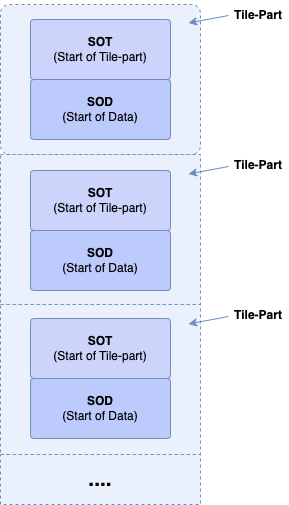

Nous aurons donc 3 tiles pour le 2K, et 6 tiles pour le 4K (3 pour le 2K, 3 pour le 4K). Mais d'où proviennent ces tiles ? Ce ne sont pas des tiles découpant l'image mais découpant les composantes (RGB ou X'Y'Z'). Chaque composante va passer séparément dans les différentes étapes de transformations :

En analysant deux JPEG2000, nous pouvons voir les différents tiles spécifiques au D-Cinema :

# Image 2K avec ses 3 tiles

$ jpeg2000-parser.py "black_2k.j2c" | grep "Start of tile-part"

[SOT] Start of tile-part ⬅ Tile 1 - Component A - 2K

[SOT] Start of tile-part ⬅ Tile 2 - Component B - 2K

[SOT] Start of tile-part ⬅ Tile 3 - Component C - 2K

# Image 4K avec ses 6 tiles

$ jpeg2000-parser.py "black_4k.j2c" | grep "Start of tile-part"

[SOT] Start of tile-part ⬅ Tile 1 - Component A - 2K

[SOT] Start of tile-part ⬅ Tile 2 - Component B - 2K

[SOT] Start of tile-part ⬅ Tile 3 - Component C - 2K

[SOT] Start of tile-part ⬅ Tile 4 - Component A - 4K

[SOT] Start of tile-part ⬅ Tile 5 - Component B - 4K

[SOT] Start of tile-part ⬅ Tile 6 - Component C - 4K

Selon le procédé (ICT ou RCT), une conversion colorimétrique est opérée soit en YCbCr (luminance + chrominance bleue + chrominance rouge), soit en YUV :

À titre indicatif, voici les différentes équations et calculs à opérer dans les cas ICT & RCT :

ICT (Irréversible, DCP) :

La conversion RGB ou X'Y'Z' à YCbCr 8 :

Y = ( 0.299 * R ) + ( 0.587 * G ) + ( 0.114 * B )

Cb = ( -0.16875 * R ) + ( -0.331260 * G ) + ( 0.5 * B )

Cr = ( 0.5 * R ) + ( -0.41869 * G ) + ( -0.08131 * B )

La transformation inverse de YCbCr à RGB ou X'Y'Z' :

R = ( 1 * Y ) + ( 0 * Cb ) + ( 1.402 * Cr )

G = ( 1 * Y ) + ( −0.34413 * Cb ) + ( −0.71414 * Cr )

B = ( 1 * Y ) + ( −1.772 * Cb ) + ( 0 * Cr )

RCT (Réversible, IMF/Archive)

Je vous invite chaudement à lire la note [8] si vous voulez en savoir plus à propos du X'Y'Z' avec ICT.

Nous générons l'ensemble des subbands (LL, HL, LH, HH) que nous avons vu précédemment : ce sont nos coefficients d'approximations et de details.

Voici l'ordre de priorisation des subbands (LL, HL, LH, HH) lors d'une recomposition :

Pour décompresser les différentes résolutions, nous commençons par lire notre tout premier

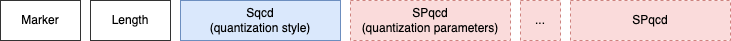

Nous allons quantifier (quantization) les données. Cela veut dire qu'on va réduire leur précision. Cette étape est destructrice, donc elle ne sera utilisée que pour le JPEG2000 CDF 9/7 pour le D-Cinema.

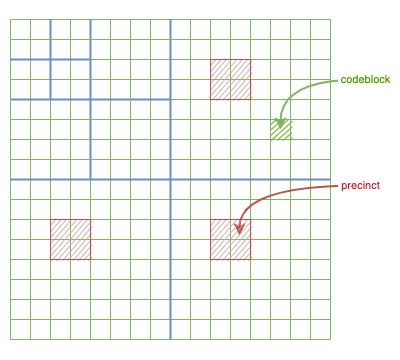

On va découper en petits blocs appelées

Les tailles des

$ jpeg2000-parser.py "black_4k.j2c" | grep "CodeBlockSize"

COD - CodeBlockSize : 32 x 32

Le codeblock est la plus petite structure géométrique d'un JPEG2000.

Les tailles des

(à l'exception dans la dernière subband où les precincts seront d'une taille de 128x128.

# Image 4K (7 résolutions) :

$ jpeg2000-parser.py "black_4k.j2c" | grep "PrecinctSize"

COD - PrecinctSize 1 : 128 x 128

COD - PrecinctSize 2 : 256 x 256

COD - PrecinctSize 3 : 256 x 256

COD - PrecinctSize 4 : 256 x 256

COD - PrecinctSize 5 : 256 x 256

COD - PrecinctSize 6 : 256 x 256

COD - PrecinctSize 7 : 256 x 256

Les precincts sont des regroupements de codeblocks.

Les precincts sont utilisés pour permettre une spécialisation d'une zone : les precincts sont des zones de l'image en commun entre les différentes subbands. Chaque precincts de chaque subbands sont liés entre elles et elles décrivent une partie de votre image. Si vous voulez reconstituer une zone particulière, il suffit de lire le precinct précis venant du HL, le precinct précis venant du HL et enfin le precinct précis venant du HH.

A titre informatif, le regroupement des 3 precincts d'une résolution spécifique est appelée Packet. Dans un paquet, vous aurez la suite des codeblocks des 3 precincts, l'un à la suite de l'autre; Voici un exemple de packet avec des precincts d'une taille de seulement de 4 codeblocks :

# ╭┄┄┄ Precinct 1 ┄┄┄╮╭┄┄┄ Precinct 2 ┄┄┄╮╭┄┄┄ Precinct 3 ┄┄┄╮

┏━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┳━━━━┓

┃ HL ┊ HL ┊ HL ┊ HL ┃ LH ┊ LH ┊ LH ┊ LH ┃ HH ┊ HH ┊ HH ┊ HH ┃

┗━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┻━━━━┛

# ╰┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄ Packet ┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄┄╯

Le nombre de résolution dans un JPEG2000 est dépendant du nombre de décomposition.

Pour savoir combien vous avez de résolution, il suffit de connaître le nombre de décomposition et de l'augmenter d'un 10 :

Resolution = ( Decomposition + 1 )

Decomposition = ( Resolution - 1 )

Notez que, selon les implémentations, le nombre de décompositions est également surnommé Wavelet Transform Levels ou parfois réduit en Decomp ou Dec.

Voici un tableau récapitulatif par résolution :

| Nombre de résolutions |

Nombre de Décompositions (Wavelet Transform Level) |

|

|---|---|---|

| Résolution 2K | 6 | 5 |

| Résolution 4K | 7 | 6 |

Analyse des différents niveaux de décomposition sur deux images 2K et 4K :

$ jpeg2000-parser.py "black_2k.j2c" | grep "Decomposition levels"

COD - Decomposition levels : 5

$ jpeg2000-parser.py "black_4k.j2c" | grep "Decomposition levels"

COD - Decomposition levels : 6

Voici les différentes résolutions que nous avons déjà vu précédemment :

| Decomposition Level |

2K | 4K |

|---|---|---|

| 1 | 2048 x 1080 | 4096 x 2160 |

| 2 | 1024 x 540 | 2048 x 1080 |

| 3 | 512 x 270 | 1024 x 540 |

| 4 | 256 x 135 | 512 x 270 |

| 5 | 128 x 68 | 256 x 135 |

| 6 | 128 × 68 |

Le fichier JPEG2000 est construit un peu comme un MXF, vous aurez différents blocs de métadonnées comprenant nos blocs de données.

Pour la suite de ce paragraphe, nous utiliserons l'image black_4k.j2c :

Un simple... écran noir, rien de plus simple ;-)

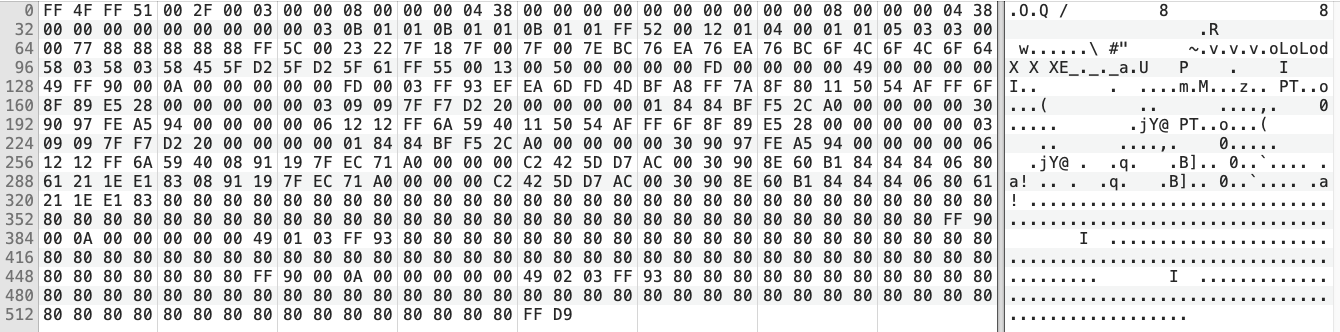

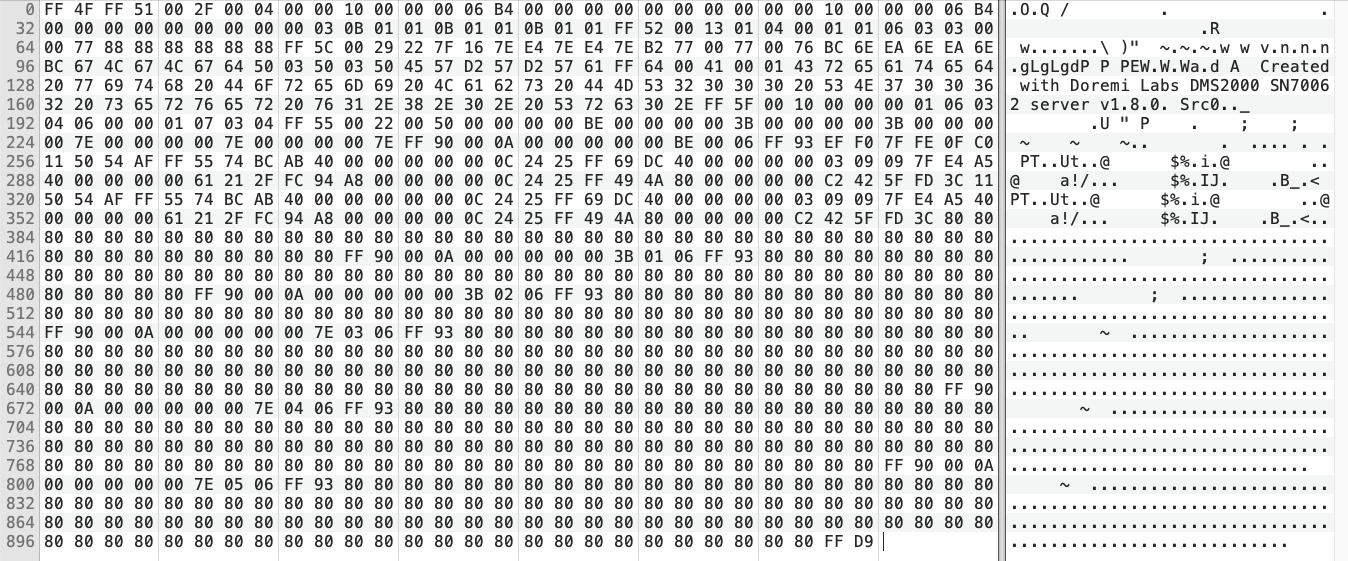

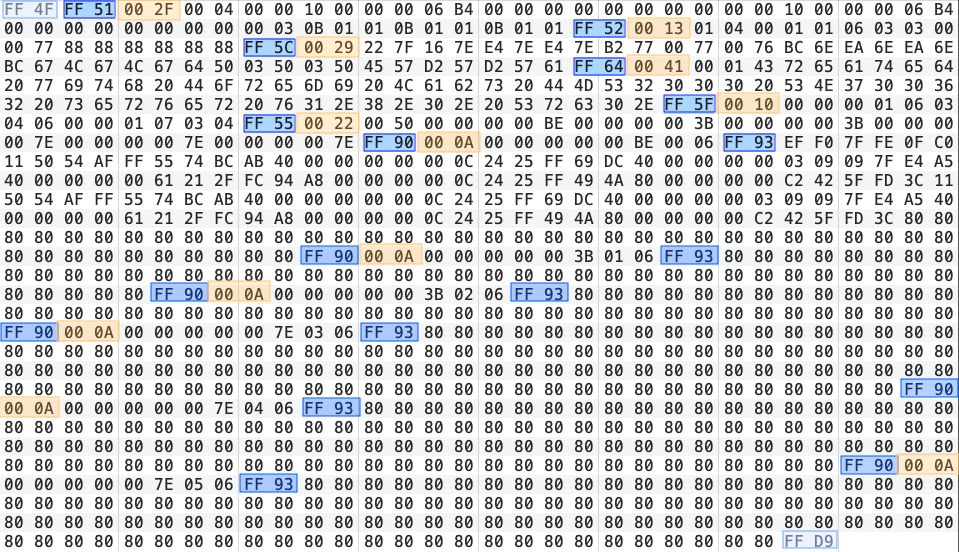

Regardons l'intérieur d'un fichier en visualisant ces données brutes à l'aide d'un éditeur hexadécimal :

Le fichier 2K :

Le fichier 4K :

Nous allons maintenant analyser les données brutes du fichier 4K.

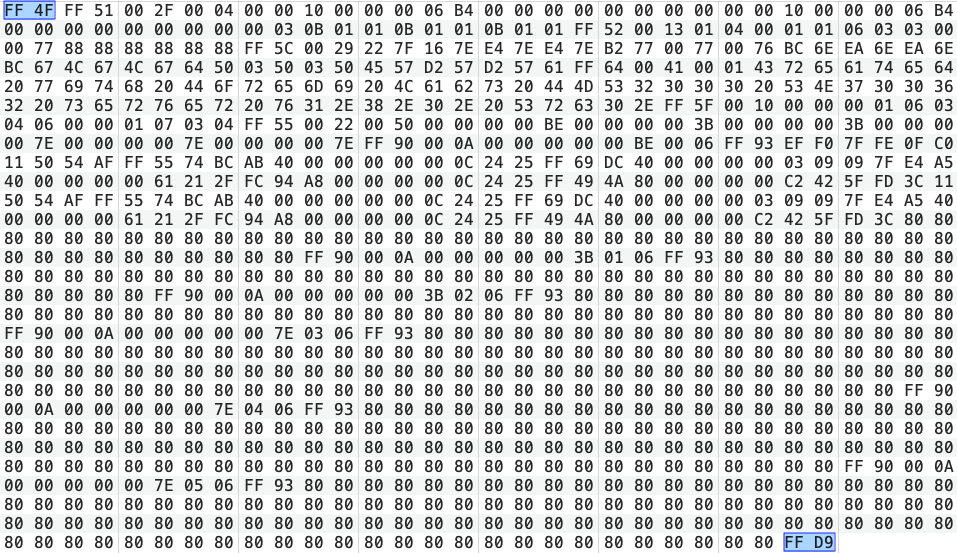

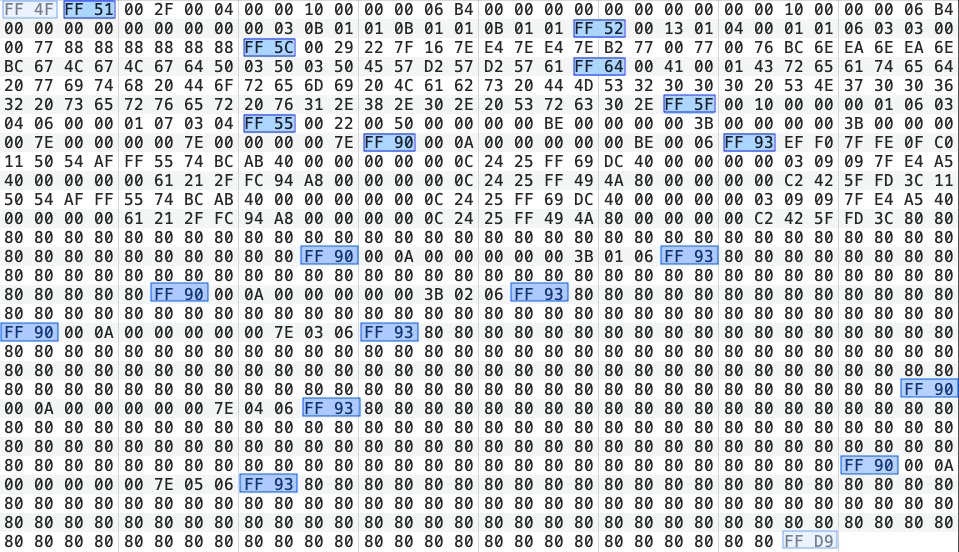

Un fichier JPEG2000 démarre toujours par un code appelé Start of Codestream avec une valeur de 0xFF4F et se termine par un code appelé End of Codestream avec une valeur de 0xFFD9 :

Ces deux markers - de 2 octets chacun - représentent un marqueur de début et de fin de fichier.

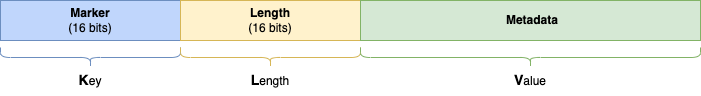

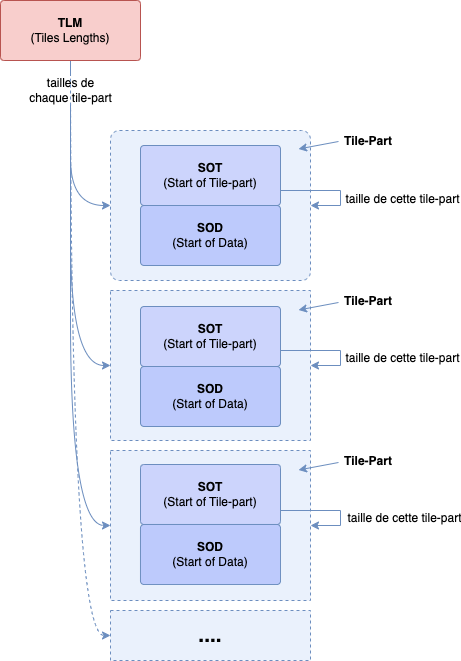

Après ce premier marker Start of Codestream, vous aurez une suite de

Les 2 octets (16 bits) qui suivent nos différents

(oubliez pour l'instant les markers FF93, ils sont particuliers...)

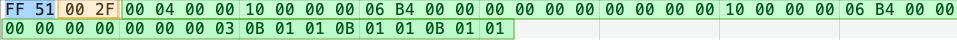

Pour notre premier bloc de métadonnées, nous avons une valeur pour la taille de 0x002F correspondant au chiffre 47 en décimal : nos données seront donc de 47 octets. Nous devons cependant retrancher les 2 octets provenant de la taille de .. la taille. La véritable taille des données est donc de 45 octets :

Si nous résumons : nous avons un identifiant (marker), une taille et des données. Cela ne vous rappelle rien ? Si vous avez lu le chapitre KLV, vous aurez déjà identifié la structure type d'un KLV 11 !

Si vous n'avez pas lu le chapitre KLV (Key-Length-Value), voici un bref résumé :

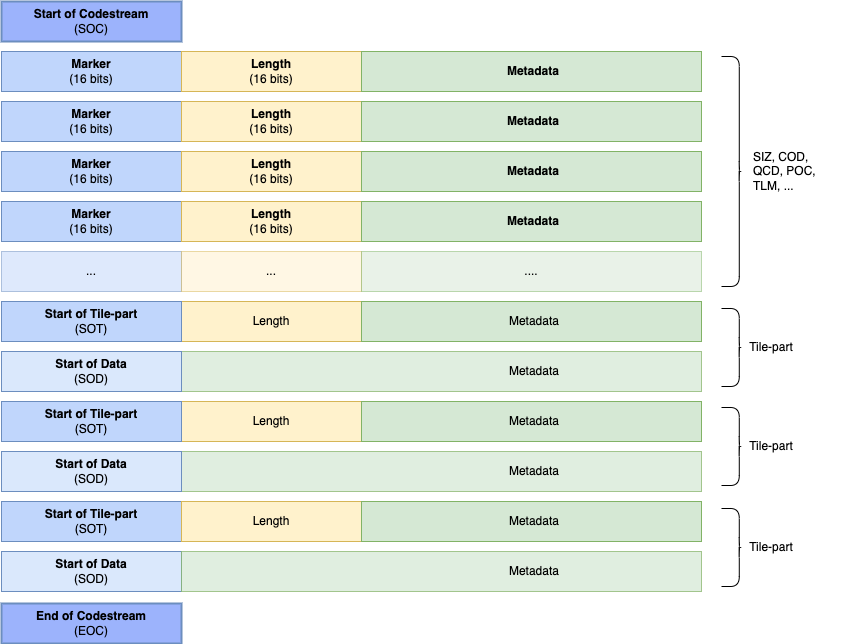

Chaque bloc de métadonnées possède un identifiant (marker), une taille et bien évidemment des données (à l'exception d'un marker appelé Start of data, il en fallait bien un...) :

Un marker (Key) est un code d'identification - d'une taille de 16 bits (2 octets) - et permettant d'identifier le type de bloc de métadonnées (KLV). Un marker débute par le code 0xFF et finit avec le code hexadécimal entre 0x01 et 0xFE

Il est suivi d'un code de taille (Length) aussi d'une taille de 16 bits (2 octets). Aucune règle particulière d'encodage, la valeur encodée est la taille. En 16 bits, votre valeur est limitée jusqu'à 65535. A noter que la taille englobe la taille du Length et Value (nos données). Lors des calculs, il faudra donc retrancher 2 octets sur la valeur pour avoir la véritable taille de Value.

Et enfin, les données (Value) : suivant le type de marker, vous aurez des métadonnées encodées respectant une certaine structure.

Voici les différents markers avec leurs codes et leurs descriptions :

| Code | Nom | Identifiant | JPEG2000 DCP |

|---|---|---|---|

| Delimiting Marker Segments | |||

| SOC | Start of codestream | 0xFF4F |

Oui |

| SOT | Start of tile-part | 0xFF90 |

Oui |

| SOD | Start of data | 0xFF93 |

Oui |

| EOC | End of codestream | 0xFFD9 |

Oui |

| Fixed Information Marker Segments | |||

| SIZ | Image and tile size | 0xFF51 |

Oui |

| Functional Marker Segments | |||

| COD | Coding style default | 0xFF52 |

Oui |

| COC | Coding style component | 0xFF53 |

Oui |

0xFF5E |

|||

| QCD | Quantization default | 0xFF5C |

Oui |

| QCC | Quantization component | 0xFF5D |

Oui |

0xFF5F |

|||

| Pointer Marker Segments | |||

| TLM | Tile-part lengths, main header | 0xFF55 |

Oui (Requis) |

| PLM | Packet length, main header | 0xFF57 |

Non |

| PLT | Packet length, tile-part header | 0xFF58 |

Non |

0xFF60 |

|||

0xFF61 |

|||

| Bitstream Marker Segments | |||

| SOP | Start of packet | 0xFF91 |

Non 12 |

| EPH | End of packet header | 0xFF92 |

Non 13 |

| Informational Marker Segments | |||

| CME | Comment and extension | 0xFF64 |

Oui (optionnel) |

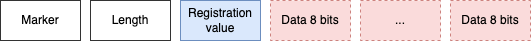

| CRG | Component registration | 0xFF63 |

Non |

En grande majorité, dans un JPEG2000 DCI, vous aurez des markers SOC, SOT, SOD, EOC, SIZ, COD, QCD, POC, TLM et CME.

Visuellement, un JPEG2000 ressemble à cela :

Nous constatons également que nous avons un mouton noir, notre Start of Data (SOD) qui ne respecte pas la structure d'un KLV :-)

Si nous prenons le fichier black_4k.j2c et nous le passons à notre analyseur :

# jpeg2000-parser.py "assets/JPEG2000/analyse/black_4k.j2c"

[SOC] Start of codestream (FF4F)

[SIZ] Image and tile size (FF51)

[COD] Coding style default (FF52)

[QCD] Quantization default (FF5C)

[CME] Comment and extension (FF64)

[POC] Progression Order Change (FF5F)

[TLM] Tile-part lengths, main header (FF55)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[SOT] Start of tile-part (FF90)

[SOD] Start of data (FF93)

[EOC] End of codestream (FFD9)

Nous voyons nos différents blocs de métadonnées, avec leurs noms de code, leurs descriptions et leurs markers.

Étudions maintenant chacun de ces blocs plus dans le détail et leurs utilités.

Un fichier JPEG2000 débute par le code 0xFF4F. Rien de plus.

Vous pouvez passer ces 16 premiers bits et aller directement à votre second marker :)

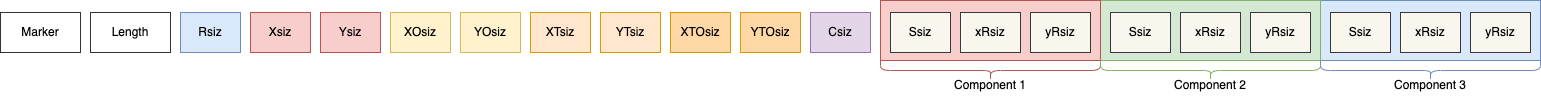

Les données sont structurées de la sorte :

Ce bloc intègre les informations sur les tailles de l'image, les nombres de composantes et des informations internes aux composantes.

[SIZ] Image and tile size (0xff51)

size: 45 bytes

data: 45 bytes readed: 000400001000000006b4000000000000000000001000000006b4000000000000000000030b01010b01010b0101

---- Provides information about the uncompressed image such as the width and height of the reference grid,

---- the width and height of the tiles, the number of components, component bit depth,

---- and the separation of component samples with respect to the reference grid

SIZ - Rsiz : Profile 4

SIZ - Xsiz : 4096 px

SIZ - Ysiz : 1716 px

SIZ - XOsiz : 0 px

SIZ - YOsiz : 0 px

SIZ - XTsiz : 4096 px

SIZ - YTsiz : 1716 px

SIZ - XTOsiz : 0 px

SIZ - YTOsiz : 0 px

SIZ - Csiz : 3 components

SIZ - Component 1 - ssizDepth : 11 ─➤ 12 bits Components Parameters (00001011)

SIZ - Component 1 - xRsiz : 1 bit(s) Horizontal separation of a sample

SIZ - Component 1 - yRsiz : 1 bit(s) Vertical separation of a sample

SIZ - Component 2 - ssizDepth : 11 ─➤ 12 bits Components Parameters (00001011)

SIZ - Component 2 - xRsiz : 1 bit(s) Horizontal separation of a sample

SIZ - Component 2 - yRsiz : 1 bit(s) Vertical separation of a sample

SIZ - Component 3 - ssizDepth : 11 ─➤ 12 bits Components Parameters (00001011)

SIZ - Component 3 - xRsiz : 1 bit(s) Horizontal separation of a sample

SIZ - Component 3 - yRsiz : 1 bit(s) Vertical separation of a sample

Une description des différentes métadonnées :

Rsiz a un nom semblant indiquer une resolution size, mais ... pas du tout :

Rsiz est un paramètre définissant le type de JPEG2000 :

0x03 (ou 0000 0000 0000 0011 en binaire)0x04 (ou 0000 0000 0000 0100 en binaire)Voici un tableau complet des différents Rsiz :

| Valeurs des bits | Description |

|---|---|

0000 0000 0000 0000 |

Capabilities spécifiée dans la recommendation |

0000 0000 0000 0001 |

Codestream restreint au Profile 0 |

0000 0000 0000 0010 |

Codestream restreint au Profile 1 |

0000 0000 0000 0011 |

2k Digital Cinema Profile |

0000 0000 0000 0100 |

4k Digital Cinema Profile |

0000 0000 0000 0101 |

Scalable 2k Digital Cinema Profile |

0000 0000 0000 0110 |

Scalable 4k Digital Cinema Profile |

0000 0000 0000 0111 |

Long-term storage Profile |

0000 0001 0000 xxxx |

Broadcast Contribution Single Tile Profile (+ Mainlevel) |

0000 0010 0000 xxxx |

Broadcast Contribution Multi-tile Profile (+ Mainlevel) |

0000 0011 0000 0110 |

Broadcast Contribution Multi-tile Reversible Profile (Mainlevel 6) |

0000 0011 0000 0111 |

Broadcast Contribution Multi-tile Reversible Profile (Mainlevel 7) |

0000 0100 yyyy xxxx |

2k IMF Single Tile Lossy Profile (+ Sublevel et Mainlevel) |

0000 0101 yyyy xxxx |

4k IMF Single Tile Lossy Profile (+ Sublevel et Mainlevel) |

0000 0110 yyyy xxxx |

8k IMF Single Tile Lossy Profile (+ Sublevel et Mainlevel) |

0000 0111 yyyy xxxx |

2k IMF Single/Multi Tile Reversible Profile (+ Sublevel et Mainlevel) |

0000 1000 yyyy xxxx |

4k IMF Single/Multi Tile Reversible Profile (+ Sublevel et Mainlevel) |

0000 1001 yyyy xxxx |

8k IMF Single/Multi Tile Reversible Profile (+ Sublevel et Mainlevel) |

Certains bits représentent des paramètres supplémentaires :

zzzz pour les Profilesyyyy pour les Sublevelxxxx pour les MainlevelLe Rsiz est surnommé parfois Codestream Capabilities.

Pour les différents Xsiz/Ysiz, XOsiz/YOsiz, XTsiz/YTsiz, XTOsiz/YTOsiz : ce sont les tailles respectives de l'image, le décalage de l'image sur la grille principale, la taille de la tile de référence et enfin des décalages possibles sur cette tile. Par chance, en DCI, Xsiz/Ysiz (image) et XTsiz/YTsiz (tile) seront de la taille de l'image et il n'existe aucun décalage donc tous les XOsiz/XTsiz et XTOsiz/YTOsiz seront à 0.

Csiz est le nombre de composants dans l'image, nous avons un XYZ ou YCbCr, donc nous serons toujours avec 3 composantes.

Pour les ssiz, xRsiz et yRsiz, ce sont des blocs par composante. Nous avons 3 composantes, donc nous aurons 3 * 3 blocs de données :

ssiz est le bitdepth de la composante. Vous obtiendrez le chiffre 11 car la norme ISO indique que la véritable valeur est ssiz + 1. Donc 12 bits. Cette valeur est la précision de la composante avant son passage en RCT ou ICT. A noter, le ssiz va utiliser les bits 1 à 8 pour encoder le chiffre. Le bit 0 sera utilisé pour spécifier si les valeurs d'origines seront unsigned (uint) ou signed (int). La valeur maximale de ssiz sera 38 bits.

xRsiz et yRsiz sont les séparations horizontales et verticales pour chaque composante. Ne pas trop s'attarder dessus, nous serons toujours avec une valeur de 1 pour spécifier "1 bit".

La structure des données se décompose ainsi :

| Nom de code | Taille | Type | Valeurs | Description |

|---|---|---|---|---|

| Marker | 16 bits | bin | 0xFF51 |

Notre fameux marker |

| Taille | 16 bits | uint | 0-65535 | Taille - 2 octets = Taille réelle des données. |

| Rsiz | 16 bits | uint | 0x03 (2K)0x04 (4K) |

Code précisant le profile du JPEG2000 |

| Xsiz | 32 bits | uint | 1 à 232 - 1 | Taille de l'image |

| Ysiz | 32 bits | uint | 1 à 232 - 1 | Taille de l'image |

| XOsiz | 32 bits | uint | 0 | Décalage dans l'image |

| YOsiz | 32 bits | uint | 0 | Décalage dans l'image |

| XTsiz | 32 bits | uint | 1 à 232 - 1 | Taille de la tile principale |

| YTsiz | 32 bits | uint | 1 à 232 - 1 | Taille de la tile principale |

| XTOsiz | 32 bits | uint | 0 | Décalage dans la tile principale |

| YTOsiz | 32 bits | uint | 0 | Décalage dans la tile principale |

| Csiz | 16 bits | uint | 0x03 |

Nombre de composant |

| ssiz (1) | 8 bits | bin | 00001011 => 1 |

Signé ou non (bit0) et Bitdepth (bit1-7) |

| xRsiz (1) | 8 bits | uint | 1 | Séparation entre composante |

| yRsiz (1) | 8 bits | uint | 1 | Séparation entre composante |

| ssiz (2) | 8 bits | bin | 00001011 => 1 |

Signé ou non (bit0) et Bitdepth (bit1-7) |

| xRsiz (2) | 8 bits | uint | 1 | Séparation entre composante |

| yRsiz (2) | 8 bits | uint | 1 | Séparation entre composante |

| ssiz (3) | 8 bits | bin | 00001011 => 1 |

Signé ou non (bit0) et Bitdepth (bit1-7) |

| xRsiz (3) | 8 bits | uint | 1 | Séparation entre composante |

| yRsiz (3) | 8 bits | uint | 1 | Séparation entre composante |

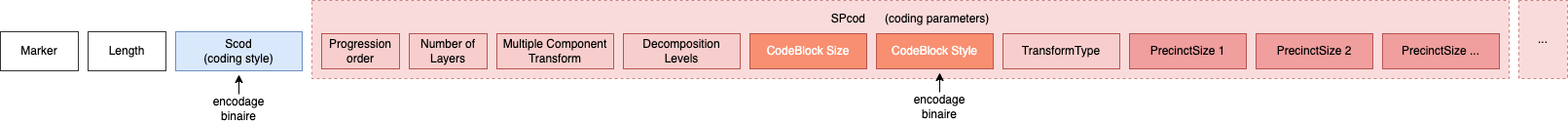

Les données sont structurées de la sorte :

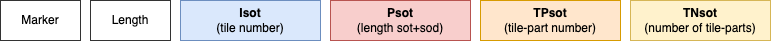

Ce bloc intègre les informations de base concernant l'encodage, la décomposition, les layers, les tailles des codeblocks et des precincts :

Scod est le style de l'encodage pour l'ensemble des composantes. Le Scod est un encodage binaire, nous aurons donc un 8 bits où chaque bit représente un paramètre (voir plus bas).

Les SPcod sont les paramètres d'encodage : nous aurons une multitude de sous-blocs qui vont permettre de définir des paramètres comme la progression order, le nombre de layers, le nombre de décomposition, les tailles des codeblocks et enfin le nombre de precincts et leurs tailles respectives :

Voici une sortie du parseur sur le bloc COD :

[COD] Coding style default (0xff52)

size: 17 bytes

data: 17 bytes readed: 0104000101060303000077888888888888

---- Describes the coding style, decomposition, and layering that is

---- the default used for compressing all components of an image or a tile

COD - Scod : 01 Binary Parameters: 00000001

COD - Progression order : 04 Binary Parameters: 00000100

COD - Number of Layers : 1

COD - Multiple Component Transform : 01 00000001

COD - Decomposition levels : 06

COD - CodeBlockSize : 32 x 32

COD - CodeBlock style : 00000000

COD - CodeBlock style parameter bit7 : No selective arithmetic coding bypass

COD - CodeBlock style parameter bit6 : No reset of context probabilities on coding pass boundaries

COD - CodeBlock style parameter bit5 : No termination on each coding pass

COD - CodeBlock style parameter bit4 : No vertically stripe causal context

COD - CodeBlock style parameter bit3 : No predictable termination

COD - CodeBlock style parameter bit2 : No segmentation symbols are used

COD - CodeBlock style parameter bit1 : Unknown parameter

COD - CodeBlock style parameter bit0 : Unknown parameter

COD - TransformType : 9-7 irreversible wavelet (00000000)

COD - PrecinctSize 1 : 128 x 128 (0111:0111)

COD - PrecinctSize 2 : 256 x 256 (1000:1000)

COD - PrecinctSize 3 : 256 x 256 (1000:1000)

COD - PrecinctSize 4 : 256 x 256 (1000:1000)

COD - PrecinctSize 5 : 256 x 256 (1000:1000)

COD - PrecinctSize 6 : 256 x 256 (1000:1000)

COD - PrecinctSize 7 : 256 x 256 (1000:1000)

La structure des données se décompose ainsi :

| Nom de code | Taille | Type | Valeurs | Description |

|---|---|---|---|---|

| Marker | 16 bits | bin | 0xFF52 |

Notre fameux marker |

| Taille | 16 bits | uint | 0-65535 |

Taille - 2 octets = Taille réelle des données |

| Scod | 8 bits | bin | 00000001 |

Code binaire avec différents paramètres par bit |

| Progression Order | 8 bits | uint | 0x04 |

Component Position Resolution Layer (CPRL) |

| Number of Layer | 16 bits | uint | 1 |

Nombre de layer, toujours à 1 |

| Multiple Component Transformation | 8 bits | uint | ||

| Decomposition Levels | 8 bits | uint | 0x05 en 2K0x06 en 4K |

Nombre de décomposition ondelettes |

| CodeBlock Size Exponent X | 8 bits | uint | 0x03 |

Nombre de l'exposant + 2 à utiliser avec le chiffre 2 |

| CodeBlock Size Exponent Y | 8 bits | uint | 0x03 |

Nombre de l'exposant + 2 à utiliser avec le chiffre 2 |

| CodeBlock Style Parameters | 8 bits | bin | 00000000 |

sera toujours à 0 (obligation DCI) |

| Transform Type | 8 bits | uint | 0000000000000001 |

9-7 irreversible wavelet (D-Cinema) 5-3 reversible wavelet (IMF) |

| Precinct Size Exponent X | 4 bits | uint | 0x70x8 |

Le premier precinct Les autres |

| Precinct Size Exponent Y | 4 bits | uint | 0x70x8 |

Le premier precinct Les autres |

Le Scod est un code en 8 bits où chaque bit représente un paramètre :

| Binaire | Description |

|---|---|

000000x0 |

Entropy coder, without partitions (precints) |

000000x1 |

Entropy coder, with partitions (precincts) |

xxxxxx0x |

No SOP marker segments used |

xxxxxx1x |

SOP marker segments may used |

xxxxx0xx |

No EPH marker segments used |